Durante la International Supercomputing Conference (ISC) di Francoforte (Germania), NVidia ha annunciato l’avvio di una stretta collaborazione con la britannica ARM incentrata sullo sviluppo di CPU progettate per il segmento high-performance computing.

La società californiana ha fatto presente che contribuirà mettendo nelle mani degli ingegneri di ARM le sue tecnologie per l’intelligenza artificiale e i sistemi per l’accelerazione hardware basati sulle GPU NVidia.

Jensen Huang, CEO di NVidia, ha spiegato che l’intesa con ARM rappresenta una vera e propria pietra miliare dal momento che consente di coniugare le prestazioni delle GPU NVidia con una piattaforma in grado di garantire eccellenti performance sul versante dei consumi energetici. E per un settore, quello HPC, che entro il 2025 varrà qualcosa come quasi 60 miliardi di dollari, è bene prendere posizione per tempo.

NVidia terrà comunque i piedi su più staffe: lo stack sul quale sta lavorando (e che dovrebbe essere presentato entro la fine di quest’anno) risulterà alla fine compatibile non solo con l’architettura ARM ma anche con x86 e IBM Power.

“L’ottenimento del cosiddetto exascale supercomputing consentirà di estendere in maniera davvero rilevante i confini della conoscenza“, ha aggiunto Huang.

Con il termine exascale computing ci si riferisce a sistemi di calcolo avanzati capaci di offrire almeno un ExaFLOPS di potenza (un miliardo di miliardi di operazioni in virgola mobile eseguite in un secondo dal processore).

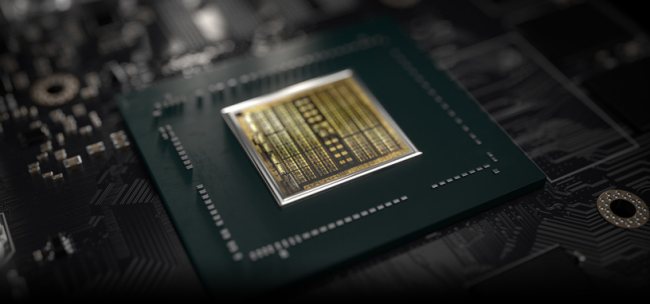

Osservando che ben 22 dei 25 supercomputer più potenti al mondo sono equipaggiati con GPU NVidia, la società ha presentato DGX SuperPOD, uno dei sistemi più performanti su scala planetaria (si calcola che sia il 22esimo in classifica per potenza).

Esso si basa su 96 NVidia DGX-2H e sulla tecnologia di interconnessione Mellanox, la stessa adoperata dalla società di Santa Clara per gestire le abilità decisionali dei nuovi sistemi per la guida autonoma.

Secondo NVidia, DGX SuperPOD sarebbe in grado di offrire fino a 9,4 PetaFLOPS di potenza con una configurazione che dimostra come in futuro sarà possibile addestrare le intelligenze artificiali con un approccio distribuito, senza utilizzare un singolo server o una sola GPU.

/https://www.ilsoftware.it/app/uploads/2023/05/img_19426.jpg)

/https://www.ilsoftware.it/app/uploads/2023/12/intelligenza-artificiale-browser-mozilla.jpg)

/https://www.ilsoftware.it/app/uploads/2025/04/SoC-intel-automotive.jpg)

/https://www.ilsoftware.it/app/uploads/2023/07/Adobe-Firefly-logo-IA-generativa-immagini-min.jpg)

/https://www.ilsoftware.it/app/uploads/2025/04/rayban-meta-occhiali-smart.jpg)