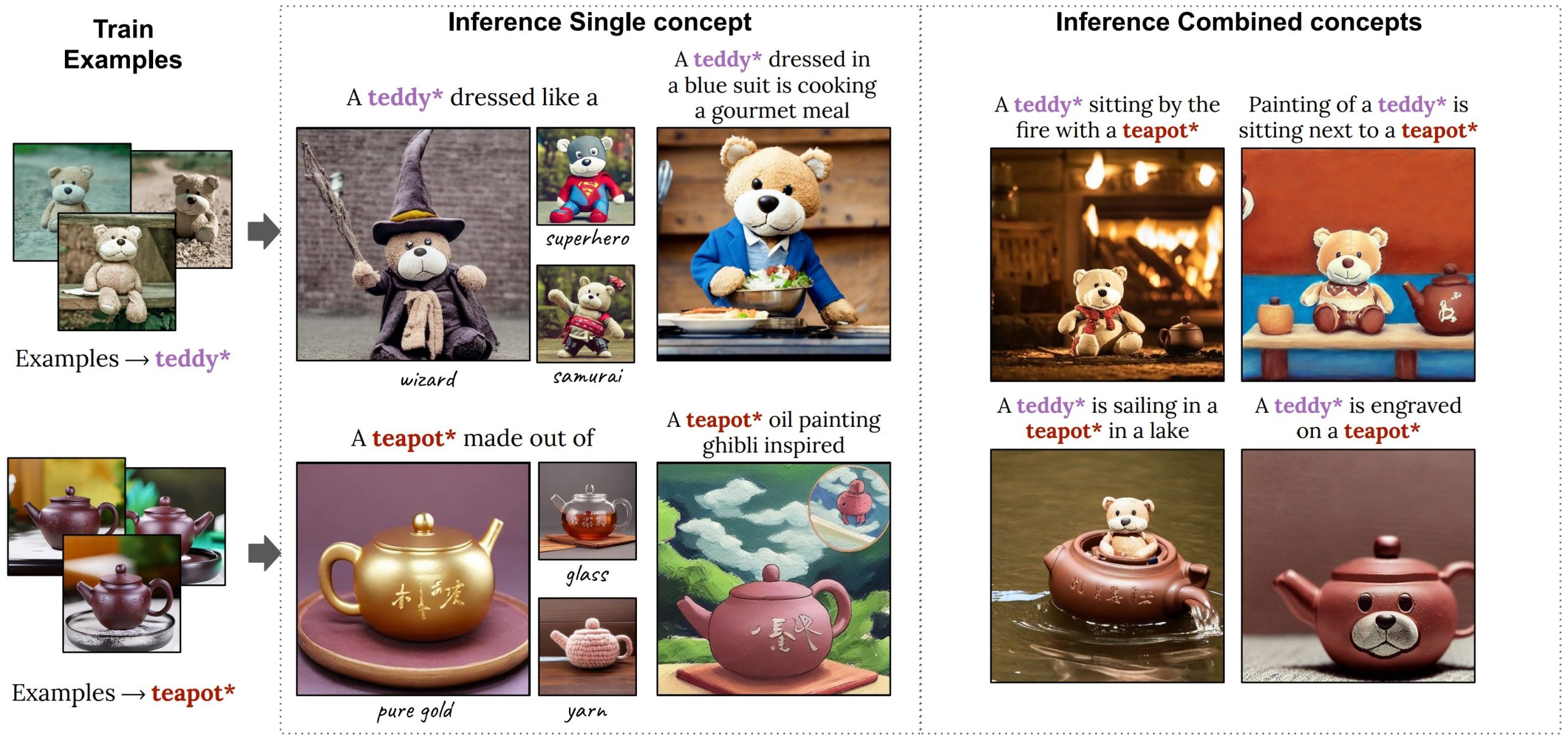

Gli sviluppatori dei moderni e più avanzati modelli generativi text-to-image si trovano di fronte a diverse sfide. NVidia Perfusion è il risultato di un nuovo approfondito studio elaborato dall’azienda fondata e guidata da Jensen Huang. Si tratta di un innovativo modello generativo che pesa appena 100 KB, un’inezia rispetto ai mastodontici progetti alternativi oggi disponibili, e che può essere sfruttato per creare immagini “inedite” a partire da semplice oppure più articolate descrizioni testuali.

I tecnici NVidia spiegano che Perfusion necessita di una fase di addestramento di circa 4 minuti e può generare contenuti visivi che rispondono alle richieste e alle indicazioni fornite in input. Gli utenti possono comunque usare il modello preaddestrato da NVidia che occupa complessivamente pochi gigabyte.

Le sfide che devono affrontare gli sviluppatori di modelli text-to-image

Prima di descrivere nel dettaglio il funzionamento di NVidia Perfusion, facciamo un passo indietro descrivendo le principali sfide che vanno affrontate nello sviluppo di modelli generativi text-to-image.

La generazione di immagini a partire da un testo è un compito complesso che richiede la creazione di modelli sofisticati e complessi. Questi modelli devono essere in grado di comprendere il contesto e le informazioni trasferite in input per creare immagini coerenti e in linea con le aspettative degli utenti.

Il linguaggio naturale può essere ambiguo e soggetto a diverse interpretazioni: un buon modello text-to-image deve interpretare in modo accurato il testo e trasformarlo in immagini che rispecchiano fedelmente la descrizione fornita in ingresso. Inoltre, è spesso necessario ricorrere a dataset di addestramento piuttosto ampi contenenti coppie di testo-immagine.

Il cosiddetto problema dell’overfitting è inoltre sempre in agguato: il modello tende ad adattarsi ai dati di addestramento. Così, i risultati ottenuti sono eccellenti se coinvolgono elementi certamente presenti nei dati di addestramenti ma mediocri con richieste più ampie e generalizzate.

Da non sottovalutare la disponibilità di controlli per gestire il processo di generazione dei contenuti visivi da parte degli utenti, i tempi di elaborazione (che in alcuni casi possono essere lunghi), la generazione di immagini che riflettono pregiudizi o stereotipi per via della provenienza e della struttura dei dati di addestramento.

Cos’è e come funziona NVidia Perfusion

Il modello NVidia Perfusion affronta tutte le sfide riassunte in precedenza. In particolare, evita l’overfitting introducendo un nuovo meccanismo che “blocca” le chiavi di attenzione correlate ai vari concetti con una categoria a loro strettamente connessa.

Le chiavi di attenzione sono uno strumento utile a determinare quali parti del testo (ad esempio, parole o frasi) devono essere prese in considerazione durante la generazione dell’immagine. In altre parole, esse servono a descrivere quale informazione testuale è rilevante per guidare il processo creativo del modello. Durante l’elaborazione, il modello assegna dei pesi differenti alle diverse chiavi di attenzione, determinando quindi l’importanza relativa delle parole e dei concetti presenti nel testo. Questo meccanismo di attenzione (ricordate il testo del 2017 dal titolo Attention Is All You Need firmato dai tecnici di Google Brain e da un gruppo di accademici, da cui tutto è partito?…) consente al modello di concentrarsi su parti specifiche del testo e di dare maggiore importanza a certi aspetti quando genera l’immagine finale.

Due parole sul Key-Locked editing introdotto da NVidia

Nel modello Perfusion di NVidia, il “blocco incrociato” (Key-Locked) delle chiavi di attenzione consente di mantenere una certa struttura e coerenza tra i concetti e le categorie di immagini personalizzate. E aiuta a ottenere risultati più fedeli e significativi.

Gli esperti di NVidia presentano anche l’innovativo approccio chiamato rank-1 gated che consente di controllare l’influenza di ciascun concetto appreso durante l’elaborazione e di combinare più concetti. In questo modo il modello può bilanciare efficacemente la fedeltà visiva dell’immagine con l’allineamento testuale durante il processo di inferenza. Il tutto senza la necessità di “sovrallenare” il modello e senza sacrificare la qualità visiva dell’immagine generata. Basti pensare, infatti, che il peso del modello – pari a soli 100 KB – è ben cinque ordini di grandezza più piccolo rispetto allo stato dell’arte attuale.

Per questo motivo, gli ingegneri di NVidia dicono che Perfusion affronta in modo intelligente le diverse sfide, evitando ad esempio che la fedeltà visiva dell’immagine generata vada a discapito dell’allineamento testuale con la descrizione fornita in input o viceversa, come generalmente accade.

Credit immagine in apertura: iStock.com/Shutthiphong Chandaeng

/https://www.ilsoftware.it/app/uploads/2023/08/nvidia-perfusion.jpg)

/https://www.ilsoftware.it/app/uploads/2025/04/SoC-intel-automotive.jpg)

/https://www.ilsoftware.it/app/uploads/2023/07/Adobe-Firefly-logo-IA-generativa-immagini-min.jpg)

/https://www.ilsoftware.it/app/uploads/2025/04/rayban-meta-occhiali-smart.jpg)

/https://www.ilsoftware.it/app/uploads/2023/08/YouTube-Logo.png)