Con la democratizzazione dell’intelligenza artificiale e l’utilizzo del machine learning, sempre più all’ordine del giorno in un vasto numero di campi applicativi, la domanda di GPU performanti è cresciuta a dismisura. Le schede basate su GPU della serie H di NVidia sono progettate sono ottimizzate per gestire carichi di lavoro specifici che richiedono elevate prestazioni di calcolo in parallelo e capacità di elaborazione importanti.

NVidia H200, il nuovo processore grafico per il calcolo ad alte prestazioni

Presentata in occasione della conferenza Supercomputing 23, NVidia H200 si configura come la GPU più potente mai creata dall’azienda di Jen-Hsun Huang. Basata sull’architettura H100 (Hopper) preesistente, H200 si mette in evidenza per l’aumento significativo della capacità di memoria e della potenza di calcolo.

H200 presenta una memoria totale pari a 141 GB HBM3E, con una velocità effettiva di circa 6,25 Gbps, per una larghezza di banda totale di 4,8 TB/s per GPU attraverso sei stack HBM3E. Si tratta di un deciso balzo in avanti rispetto alla GPU precedente, H100, che sfruttava 80 GB di memoria HBM3 e offriva una larghezza di banda di 3,35 TB/s.

Le prestazioni di calcolo grezze non sembrano subire cambiamenti significativi rispetto all’H100, con una potenza di calcolo totale di 32 PFLOPS in FP8 utilizzando configurazioni a otto GPU. NVidia sostiene che, in scenari di lavoro che beneficiano notevolmente dalla maggiore capacità di memoria, come nel caso dei modelli linguistici di grandi dimensioni (LLM) come GPT-3, H200 può offrire un aumento delle prestazioni fino a 18 volte rispetto a una GPU A100 originale, superando l’H100 di 11 volte.

Le GPU H200 andranno ovviamente ad alimentare i supercomputer di nuova generazione, capaci di spingersi oltre i 200 exaFLOPS in termini di potenza di calcolo e attesi entro fine 2024.

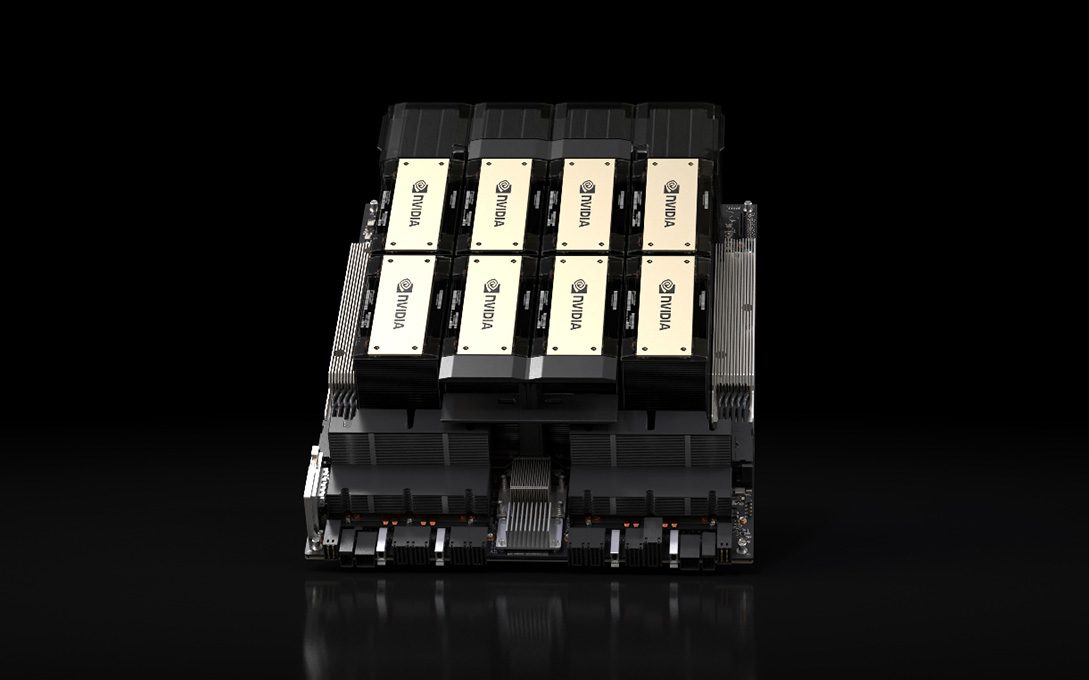

Piattaforma HGX H200 e Quad GH200

Oltre alla GPU H200, NVidia ha presentato anche la piattaforma HGX H200, progettata per sfruttare le potenzialità della nuova GPU. La HGX H200 mantiene la compatibilità con i sistemi esistenti HGX H100, consentendo un aggiornamento delle prestazioni e della capacità di memoria senza dover ridisegnare l’infrastruttura. Questo rende la transizione relativamente semplice per i costruttori di sistemi server.

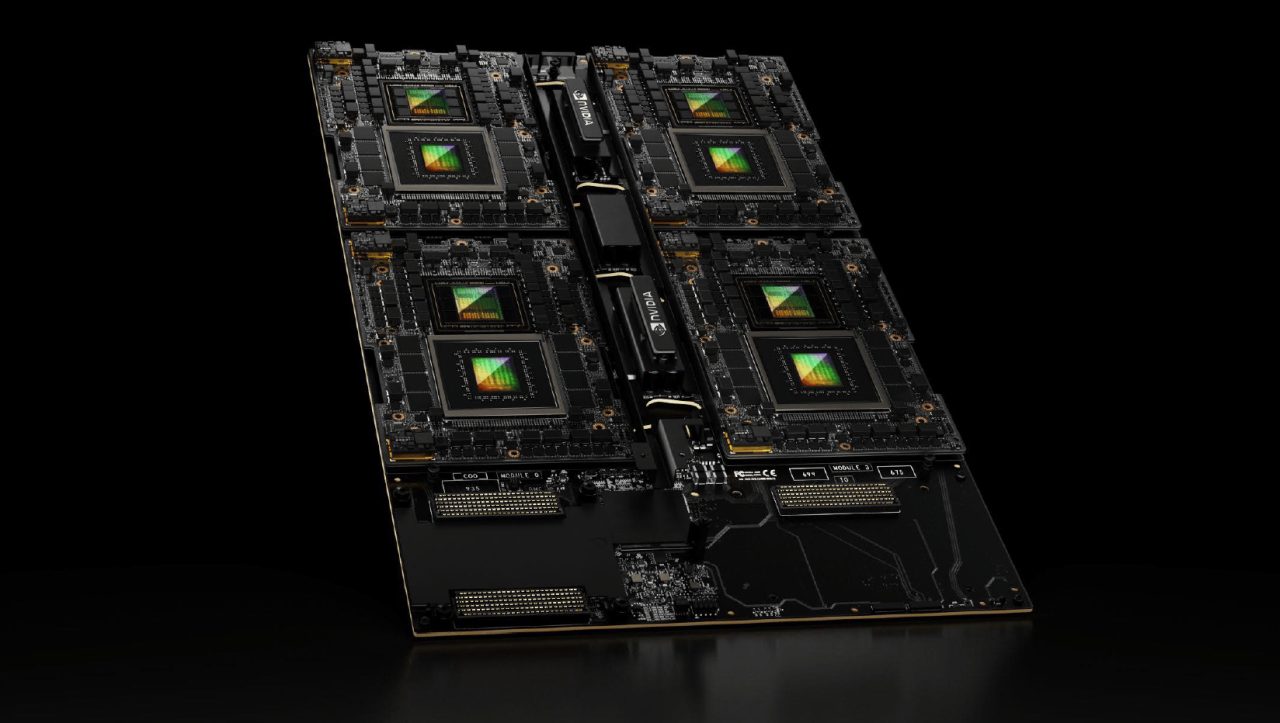

La scheda Quad GH200, invece, è una scheda che ospita quattro acceleratori GH200 ed offre 288 core ARM per un totale di ben 2,3 TB di memoria ad alta velocità. La soluzione, che include CPU Grace e GPU Hopper, è pensata per essere utilizzata come elemento di base per sistemi più ampi, sfruttando una topologia NVLink 4-way per la connessione tra i quattro acceleratori.

Mentre H200 è una GPU stand-alone progettata come un aggiornamento rispetto alla precedente H100, GH200 è una soluzione più completa che combina la GPU H200 con la CPU Grace. La GH200 è presentata come un “superchip” che offre un equilibrio tra potenza di calcolo e capacità di gestione della memoria.

Supercomputer Jupiter, soluzione per le applicazioni di intelligenza artificiale e HPC

Con 23.762 nodi GH200, Jupiter è ad oggi il più grande supercomputer basato sull’architettura Hopper. Nato da una collaborazione tra NVidia e EuroHPC Joint Undertaking, il supercomputer rappresenta la prima implementazione su larga scala dell’architettura Hopper volta a supportare carichi di lavoro HPC tradizionali oltre alle attività di IA a bassa precisione.

Con i suoi 93 exaFLOPS di prestazioni nelle applicazioni di intelligenza artificiale a bassa precisione e oltre 1 exaFLOPS ad alta precisione (FP64) per carichi di lavoro HPC, è destinato a essere un protagonista nella ricerca climatica, scientifica dei materiali, scoperta di farmaci, ingegneria industriale e calcolo quantistico. Tant’è vero che un esemplare sarà installato presso il centro di ricerca Forschungszentrum Jülich in Germania.

/https://www.ilsoftware.it/app/uploads/2023/11/nvidia-H200-GPU.jpg)

/https://www.ilsoftware.it/app/uploads/2025/02/NVIDIA.jpg)

/https://www.ilsoftware.it/app/uploads/2025/04/oppo-a5-pro-5g.jpg)

/https://www.ilsoftware.it/app/uploads/2025/04/memoria-HBM4.jpg)

/https://www.ilsoftware.it/app/uploads/2025/04/flux_image_475589_1744881349.jpeg)