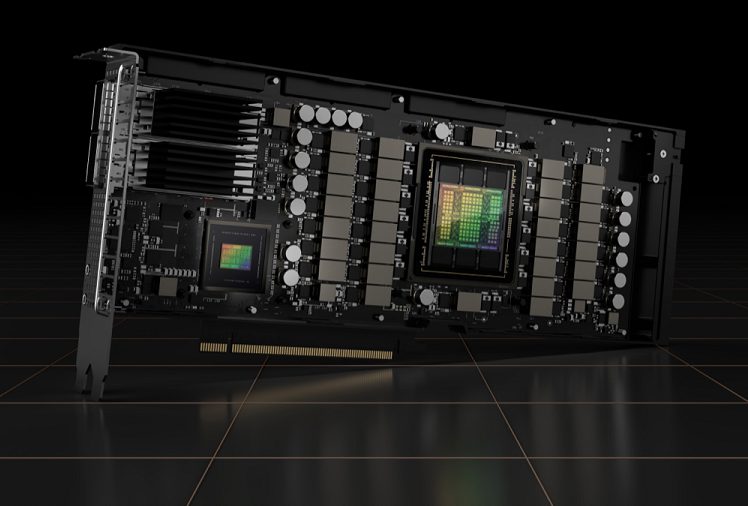

NVidia vanta un ricco catalogo di soluzioni per l’intelligenza artificiale e l’utilizzo in ambito data center. NVidia H100 sono schede avanzate che poggiano il loro funzionamento su Tensor Core per accelerare i calcoli ad alte prestazioni e il funzionamento delle applicazioni AI.

Più acceleratori H100 di NVidia vengono abitualmente affiancati sui sistemi chiamati a gestire carichi di lavoro impegnativi. Con NVLink Switch System, è possibile collegare fino a 256 H100 per accelerare i carichi di lavoro exascale (la comunicazione avviene fino a 900 GB/s). L’espressione “carichi di lavoro exascale” si riferisce a workload informatici complessi che richiedono una potenza di calcolo di almeno un exaflop, ovvero 1018 operazioni in virgola mobile al secondo.

Carichi di lavoro exascale sono figli di ricerche in ambito scientifico, operazioni di analisi dei dati, modellazione e simulazione di fenomeni complessi, elaborazioni legate all’intelligenza artificiale, deep learning e altre applicazioni ad elevata intensità computazionale.

Gli acceleratori NVidia sono progettati per eseguire un gran numero di operazioni in parallelo risultando particolarmente adatti per il calcolo scientifico, l’intelligenza artificiale, il machine learning, la simulazione, la visualizzazione 3D e molto altro ancora. Basti pensare che il chatbot Inflection AI poggia il suo funzionamento su 22.000 schede H100.

Cosa significa poter utilizzare le GPU NVidia H100 su AWS Cloud

Il cloud offre la possibilità di svincolarsi da qualunque investimento “sul ferro”. Grazie all’integrazione di NVidia H100 con AWS Cloud, professionisti, sviluppatori e ricercatori sono in grado di utilizzare le GPU ultra-performanti senza fare alcun acquisto in proprio.

In altre parole, non è necessario comprare una o più schede H100 e installarle in locale. Con un account AWS Cloud, è possibile accedere alla piattaforma di Amazon e iniziare a sfruttare i benefici dell’offerta NVidia sul cloud.

AWS Cloud permette alle aziende e agli sviluppatori di ospitare applicazioni, memorizzare dati e sfruttare altre funzionalità avanzate senza dover gestire fisicamente l’infrastruttura sottostante. Questo rende possibile eseguire applicazioni in modo affidabile e scalabile, riducendo i costi e migliorando l’efficienza.

La nuova istanza Amazon EC2 P5 dà modo di utilizzare subito le schede H100 per i propri progetti selezionando il profilo dal pannello di amministrazione di AWS Cloud.

Le istanze P5 sono ideali, ad esempio, per l’addestramento e l’esecuzione di inferenza su modelli linguistici di grandi dimensioni (LLM) oltre che per il supporto dei moderni modelli di visione artificiale. Grazie alle reti neurali che si possono così gestire, le IA generative possono rispondere alle domande, generare codice, video e immagini, abilitare il riconoscimento vocale e altro ancora.

Cosa sono i cluster hyperscale

I cluster hyperscale sono grandi infrastrutture di calcolo altamente scalabili e distribuite, progettate per supportare carichi di lavoro ad alta intensità computazionale e di elaborazione dati. Sono formati da un gran numero di server interconnessi che lavorano insieme in modo coordinato per fornire prestazioni elevate e risorse di calcolo su larga scala.

Le istanze P5 di AWS Cloud possono essere implementate in cluster hyperscale EC2 UltraClusters, costituiti da elaborazione ad alte prestazioni, networking e storage interamente basati sul cloud. Ogni EC2 UltraCluster è un potente supercomputer, che consente agli utenti di eseguire le attività di intelligenza artificiale più complesse e gestire carichi di lavoro HPC (High Performance Computing) distribuiti su più sistemi.

Affinché i clienti possano eseguire applicazioni su larga scala che richiedono elevati livelli di comunicazione tra i nodi di calcolo, l’istanza P5 offre reti di classe petabit, alimentate da AWS EFA, un’interfaccia di rete da 3.200 Gbps per istanze Amazon EC2.

Per rendersi conto di quanto AWS Cloud riesca a mettere nelle mani di tutte le realtà d’impresa strumenti estremamente potenti, basti pensare che le nuove istanze P5 offrono la possibilità di utilizzare la NVidia Collective Communications Library che abilita il supporto per qualunque numero di GPU H100, fino a 20.000 nell’ambito del medesimo progetto.

NVidia AI Enterprise aiuta inoltre gli utenti a ottenere il massimo dalle istanze P5 con una suite software completa che include più di 100 framework, modelli pre-addestrati, flussi di lavoro AI e strumenti per ottimizzare l’infrastruttura AI.

/https://www.ilsoftware.it/app/uploads/2023/07/nvidia-H100-GPU-acceleratore.jpg)

/https://www.ilsoftware.it/app/uploads/2023/12/intelligenza-artificiale-browser-mozilla.jpg)

/https://www.ilsoftware.it/app/uploads/2025/04/SoC-intel-automotive.jpg)

/https://www.ilsoftware.it/app/uploads/2023/07/Adobe-Firefly-logo-IA-generativa-immagini-min.jpg)

/https://www.ilsoftware.it/app/uploads/2025/04/rayban-meta-occhiali-smart.jpg)