La notizia è ormai ampiamente nota: John Hopfield e Geoffrey Hinton sono i vincitori del Premio Nobel per la Fisica 2024, assegnato loro per le “scoperte e invenzioni fondamentali che consentono l’apprendimento automatico grazie all’utilizzo di reti neurali artificiali“. Il riconoscimento sottolinea il ruolo pionieristico dei due docenti accademici nello sviluppo di tecnologie che hanno letteralmente rivoluzionato il campo dell’intelligenza artificiale.

Geoffrey Hinton, 76 anni, inglese, professore presso l’Università di Toronto, è spesso definito il “padrino dell’intelligenza artificiale“. Ha infatti sviluppato metodi innovativi nel campo del deep learning, fondamentali per lo sviluppo dei moderni modelli generativi e in generale dei Large Language Model (LLM) come GPT.

A maggio 2023, Hinton aveva deciso di lasciare Google, azienda con cui collaborava, con l’obiettivo di esaminare le implicazioni etiche e i potenziali rischi dell’intelligenza artificiale (IA). All’epoca Hinton dichiarò che la sua scelta non era una critica nei confronti di Google, che anzi aveva agito responsabilmente, ma una mossa tesa a non danneggiare l’azienda nello sviluppo delle sue soluzioni.

John Hopfield, classe 1933, professore emerito alla Princeton University, è di Chicago (USA) e ha lavorato su modelli di reti neurali che imitano la memoria associativa del cervello umano. La sua ricerca ha portato alla creazione della cosiddetta rete di Hopfield, un modello capace di archiviare e ricostruire dati complessi, ad esempio le immagini.

Come funzionano le reti neurali artificiali di Hinton e Hopfield

Innanzi tutto, perché il Nobel per la fisica va a due esperti che si sono prodigati nel campo dell’intelligenza artificiale? Perché Hinton e Hopfield hanno sfruttato principi della fisica per elaborare le loro idee e partorire tecnologie che sono oggi alla base delle attuali IA.

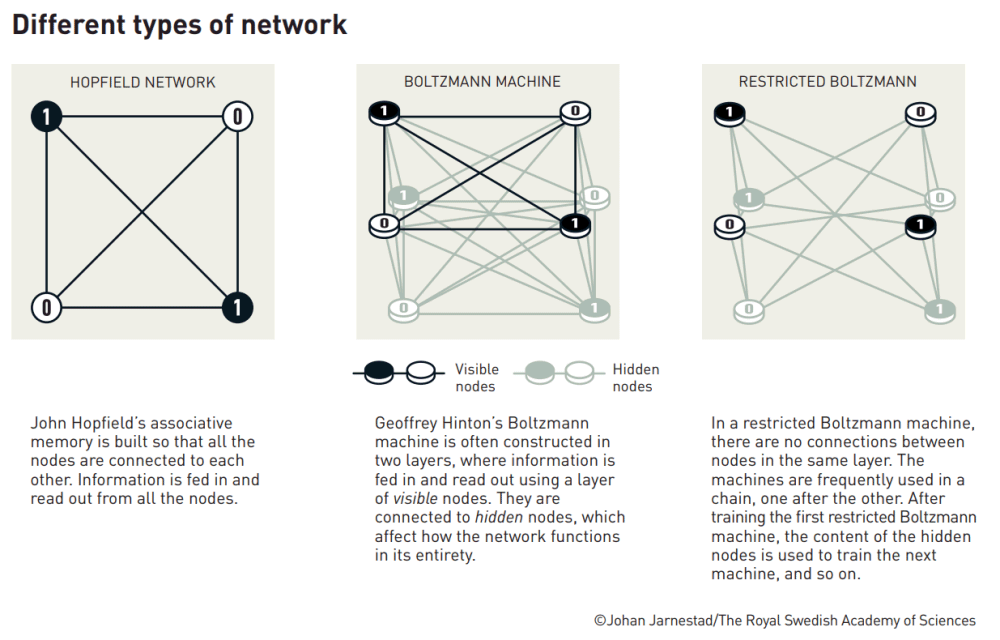

Come accennato nell’introduzione, Hopfield ha creato una rete associativa capace di memorizzare e ricostruire immagini e altri tipi di pattern nei dati. La rete di Hopfield funziona in modo simile al sistema di spin atomici nella fisica dei materiali. I nodi della rete, che possiamo immaginare come i pixel di un’immagine, interagiscono tra loro attraverso connessioni che ricordano le sinapsi del cervello umano. Il sistema è addestrato a individuare valori ottimali per le connessioni tra i nodi, in modo che le immagini salvate abbiano una “bassa energia”. Quando la rete è alimentata con un’immagine distorta o incompleta, lavora progressivamente per “abbassare l’energia del sistema”, trovando l’immagine originale più simile.

Hinton, basandosi sul lavoro svolto dal collega Hopfield, ha sviluppato la macchina di Boltzmann, un tipo di rete neurale che può “imparare a riconoscere” elementi caratteristici all’interno di dati specifici. Usando strumenti della fisica statistica, la macchina di Boltzmann è addestrata alimentandola con esempi che si verificano frequentemente. La tecnologia messa a punto da Hinton ha successivamente aperto la strada al riconoscimento automatico delle immagini e alla generazione di modelli evoluti a partire da un insieme di dati di addestramento.

Cos’è una rete neurale artificiale

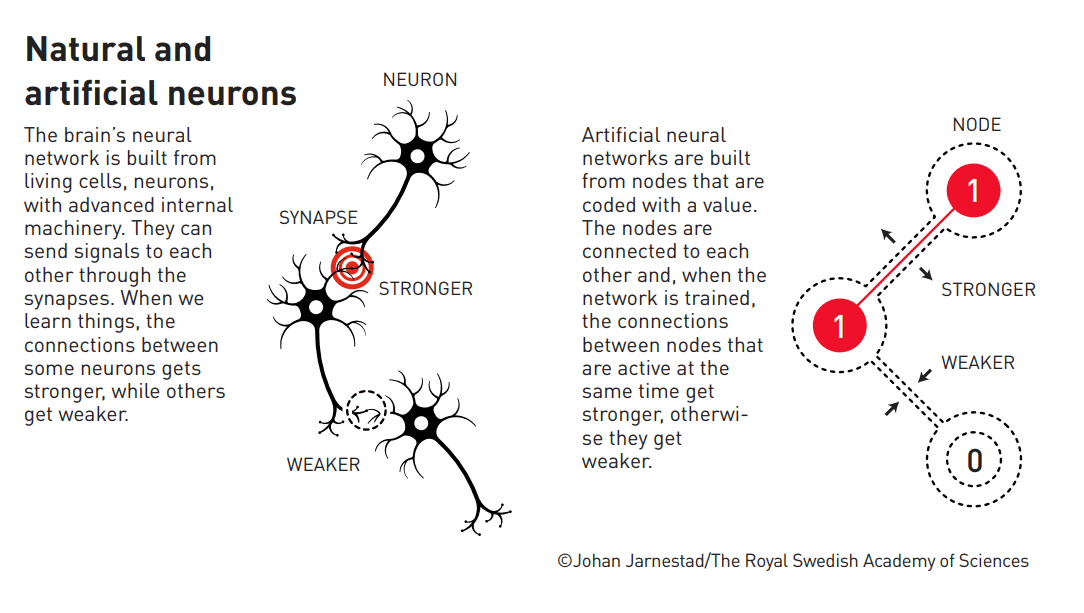

Le reti neurali artificiali (ANN) sono modelli di apprendimento automatico che traggono ispirazione dai meccanismi cerebrali. Utilizzano neuroni artificiali strutturati in unità di calcolo interconnesse a strati e con un “peso” differente.

Il cosiddetto aggiustamento dei pesi è un’attività essenziale per migliorare le capacità della rete di compiere una specifica azione: classificazione di dati, generazione di testo, regressione e così via. La regressione è un modello statistico sfruttato per predire o stimare il valore di una variabile dipendente basandosi sui valori di una o più variabili indipendenti. L’obiettivo è infatti quello di stabilire come una variabile sia correlata a un’altra variabile o ne influenzi l’andamento.

Rete di Hopfield

Introdotta nel lontano 1982, la rete di Hopfield è una rete neurale ricorrente progettata per il completamento di pattern e la memorizzazione associativa. Si basa su nodi binari (che rappresentano stati neurali) collegati tramite connessioni sinaptiche ponderate.

Il funzionamento della rete di Hopfield si ispira a fenomeni collettivi tipici dei sistemi fisici. Ogni nodo può assumere uno stato attivo o inattivo (0 o 1), determinato da una somma pesata degli input ricevuti dagli altri nodi. La rete è in grado di “apprendere” configurazioni specifiche attraverso una regola “ad hoc”, in cui il peso delle connessioni tra i nodi aumenta se i nodi attivati simultaneamente si rinforzano a vicenda.

Uno degli aspetti più interessanti del modello di Hopfield è il concetto dell'”N-dimensional energy landscape“. La rete evolve verso stati di energia minima, che corrispondono alle configurazioni di pattern salvate in precedenza. Se la rete riceve un input incompleto o distorto, lavora per trovare la configurazione salvata che minimizza l’energia del sistema, completando il pattern iniziale. Il modello di Hopfield ha evidentemente trovato molteplici applicazioni pratiche nel riconoscimento delle immagini e nella correzione degli errori.

Macchina di Boltzmann e contributi di Hinton

Hinton ha a sua volta ripreso ed esteso gli studi di Hopfield con la già citata macchina di Boltzmann. Si tratta di un modello stocastico capace di apprendere distribuzioni di probabilità complesse.

A differenza della rete di Hopfield, che si concentra su pattern specifici, la macchina di Boltzmann “apprende” intere distribuzioni di dati. Ed è quindi qualcosa di molto simile a ciò che fanno i moderni LLM, ad esempio. La capacità di generare output non è completamente determinata da un insieme fisso di parametri o da condizioni iniziali. I modelli introducono elementi probabilistici nel processo di generazione, con l’output che può variare anche in maniera significativa, anche a partire da uguali condizioni iniziali (si pensi a uno stesso prompt inviato a un chatbot che produce risposte molto diverse…).

Nel caso della macchina di Boltzmann, Hinton ha utilizzato nodi visibili (che rappresentano dati osservabili) e nodi nascosti (che permettono di modellare relazioni complesse nei dati). Il processo di apprendimento consiste nell’ottimizzazione dei pesi delle interconnessioni tra i nodi, in modo che la distribuzione statistica generata dalla rete rispecchi quella dei dati di addestramento.

Perché la macchina di Boltzmann si chiama così: i legami con la fisica

Ludwig Boltzmann è un fisico austriaco (1844-1906) noto per il suo fondamentale contributo alla statistica e alla termodinamica. Le sue idee hanno rivoluzionato la comprensione della materia a livello molecolare e sono alla base di molte aree della fisica moderna.

Hinton ha scelto il nome macchina di Boltzmann per la sua rete neurale perché fa perno su di un modello termodinamico che descrive come le particelle in un sistema fisico si distribuiscono tra diversi stati energetici. Trasponendo il lavoro sul versante del machine learning, ciò significa che la rete di Hinton può essere addestrata a riconoscere caratteristiche distintive nei dati e a generare nuovi esempi di dati simili a quelli su cui è stata addestrata. È proprio “il sale” del funzionamento dei modelli generativi con cui molti di noi si interfacciano oggi.

Una variante dell’architettura, la macchina di Boltzmann ristretta (RBM), è stata utilizzata da Hinton per facilitare l’apprendimento nelle reti neurali profonde, un passo cruciale nello sviluppo del deep learning. RBM prevede che le connessioni tra nodi esistano solo tra i nodi visibili e quelli nascosti, senza connessioni tra nodi dello stesso tipo. Uno schema “vincente” che ha permesso l’addestramento più efficiente di reti multilivello, utilizzate per applicazioni come la riduzione dimensionale e la classificazione.

La riduzione dimensionale è un processo utilizzato per ridurre il numero di variabili o “dimensioni” in un set di dati, mantenendo il più possibile le informazioni significative. La classificazione, invece, è un compito di apprendimento supervisionato in cui l’obiettivo è assegnare etichette o categorie a nuovi dati basandosi sul modello precedentemente addestrato.

Credit immagini pubblicate nell’articolo: ©Johan Jarnestad/The Royal Swedish Academy of Sciences; credit immagine in apertura: iStock.com – rrodrickbeiler

/https://www.ilsoftware.it/app/uploads/2024/10/premio-nobel-fisica-hinton-ai-hopfield-reti-neurali.jpg)

/https://www.ilsoftware.it/app/uploads/2024/12/3-11.jpg)

/https://www.ilsoftware.it/app/uploads/2025/04/whatsapp-automazione-claude-AI.jpg)

/https://www.ilsoftware.it/app/uploads/2025/04/vulnerabilita-bootloader-AI.jpg)

/https://www.ilsoftware.it/app/uploads/2023/07/ChatGPT-su-smartphone-Android.png)