/https://www.ilsoftware.it/app/uploads/2024/02/mistral-large-le-chat-chatbot.jpg)

Mistral AI è una startup francese specializzata nell’intelligenza artificiale e fondata da ex Google (DeepMind) e Meta nell’aprile 2023. La società è nota per il suo approccio aperto poiché mette a disposizione modelli generativi innovativi, flessibili e accessibili, che sfidano il predominio delle grandi aziende tecnologiche del settore.

C’è anche un po’ di Italia nel lavoro di Mistral AI poiché, come abbiamo visto nell’articolo dedicato alle alternative open source a ChatGPT, l’azienda ha sfruttato il supercomputer Leonardo (Consorzio CINECA) per l’impegnativa fase di addestramento del modello.

Sorpresa: Mistral AI rilascia un avveniristico modello aperto 8x22B MoE. Ecco cosa cambia

Senza suonare la grancassa, Mistral AI ha messo a punto e reso disponibile il nuovo modello 8x22B MoE. Sebbene diversi dettagli siano ancora sconosciuti, il modello sembra poter disporre di tre volte il numero dei parametri che contraddistinguono Mistral 8x7B, già in grado di superare GPT-3.5 (OpenAI) and Llama 2 70B (Meta) in molteplici benchmark.

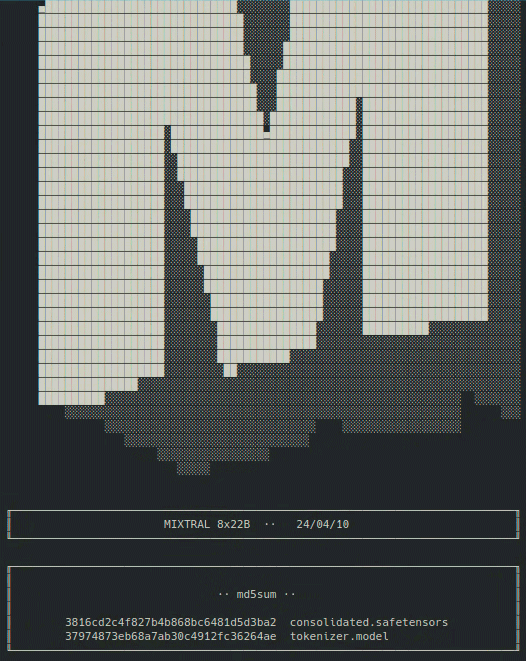

Come spiegato in questo post su X, 8x22B MoE risulta al momento scaricabile esclusivamente attraverso la rete BitTorrent, utilizzando il magnet link indicato. Quest’ultimo è un tipo di URL utilizzato per identificare e accedere ai file torrent su reti peer-to-peer. A differenza degli URL tradizionali, i magnet link non contengono informazioni dirette sui file o sui tracker. Invece, includono solo un identificatore univoco, noto come hash, utilizzato dai client BitTorrent per individuare e scaricare i file desiderati.

Il file del modello condiviso da Mistral AI è veramente pesante: basti pensare che supera i 260 GB in termini di dimensione. Per questo motivo, con il preciso intento di ridurre la banda di rete impegnata, la startup ha deciso di renderlo disponibile per ora solo tramite BitTorrent (si può usare qualunque client compatibile per scaricarlo).

Cos’è un LLM (Large Language Model) di tipo MoE (Mixture of Experts)

Un Large Language Model (LLM) MoE (Mixture of Experts) è un modello che, per la generazione dell’output nel linguaggio naturale, si appoggia a una tipologia di architettura di rete neurale che combina più modelli “esperti” (o “sottoreti”) per gestire diversi aspetti di un compito complesso. Ogni esperto è specializzato in una determinata parte del problema, e un’altra rete, chiamata “gate network“, determina a quale esperto assegnare ciascuna parte dell’input.

In un LLM MoE, quindi, diversi sotto-modelli (gli “esperti”) cooperano per migliorare le prestazioni complessive. Ogni esperto è addestrato su un sottoinsieme dei dati ed è specializzato in una particolare area del linguaggio.

Gli esperti lavorano in parallelo e il risultato finale è una combinazione delle loro uscite pesate dal gate. Questo genere di approccio consente al modello di adattarsi in modo dinamico a diverse parti del testo, sfruttando le specializzazioni degli esperti per migliorare le complessive capacità di comprensione e generazione del linguaggio.

Mistral AI 8x22B MoE è proprio questo, un modello basato su una potente e intelligente architettura che sfrutta l’idea di esperti specializzati, capaci di lavorare assieme per gestire in modo efficiente e accurato compiti complessi nel linguaggio naturale.

Un’ampia finestra di contesto: 65k token

Con l’espressione finestra di contesto ci si riferisce alla quantità di testo che il modello generativo prende in considerazione quando genera una risposta o fa una predizione su una determinata porzione di testo. Come suggerisce il nome, si tratta proprio del “contesto” che il modello utilizza per “comprendere” il prompt dell’utente e rispondere a tono, in maniera il più possibile pertinente ed esaustiva, alla richiesta o alla domanda.

Una finestra di contesto ampia 65k, come nel caso del nuovo modello 8x22B MoE di Mistral AI, suggerisce che l’IA è di fatto in grado di considerare fino a 65.536 token di testo, dove un “token” può essere una parola, una cifra, un segno di punteggiatura o qualsiasi altra unità di testo separata.

Un valore così esteso per la finestra di contesto (context window, in inglese) dà modo al modello di elaborare e gestire una vasta gamma di informazioni contestuali quando prende in esame l’input e si appresta a generare una risposta.

Il futuro dell’intelligenza artificiale firmato Mistral AI

Un po’ come ha fatto OpenAI, che si è allontanata dall’approccio aperto perseguito agli albori (facendo andare su tutte le furie Elon Musk), Mistral AI ha rilasciato sia modelli open source come Mixtral 8x7B (e adesso il nuovo 8x22B MoE), sia modelli commerciali come ‘Mistral Small‘, ‘Mistral Embed‘ e ‘Mistral Large‘.

La startup transalpina ha già raccolto più di 385 milioni di euro da venture capital come Andreessen Horowitz e Lightspeed Venture Partners, e la sua valutazione ha raggiunto circa 1,8 miliardi di euro. A febbraio 2024, Mistral AI ha firmato un accordo di partnership pluriennale con Microsoft ottenendo un investimento di 15 milioni di euro. L’iniziativa commerciale è comunque al vaglio delle Autorità regolatorie dell’Unione Europea, che stanno valutando eventuali impatti negativi sul piano della concorrenza.

Oltre al rilascio dei modelli sopra citati, Mistral AI offre anche un servizio di chat AI chiamato Le Chat. Il modello open source può inoltre essere utilizzato anche con il chatbot gratuito di NVIDIA, chiamato Chat With RTX.

/https://www.ilsoftware.it/app/uploads/2025/12/wp_drafter_493242.jpg)

/https://www.ilsoftware.it/app/uploads/2025/08/notebooklm-audio-video-overview-italiano.jpg)

/https://www.ilsoftware.it/app/uploads/2025/03/94.jpg)

/https://www.ilsoftware.it/app/uploads/2024/12/3-11.jpg)