Sapevamo che gli ingegneri di Meta erano al lavoro già da tempo sull’addestramento del modello generativo Llama 3. Progettato per superare i limiti delle attuali soluzioni di intelligenza artificiale, il nuovo Llama 3 (che dovrebbe essere pubblicamente rilasciato a luglio 2024) dovrebbe consentire lo sviluppo di “capacità cognitive” complesse, senza però dimenticarci che abbiamo comunque a che fare con modelli stocastici.

Diversamente rispetto a modelli chiusi e proprietari come OpenAI GPT-4 e Google Gemini, Meta Llama 3 sarà open source e offrirà numerose possibilità di personalizzazione a tutto vantaggio degli sviluppatori.

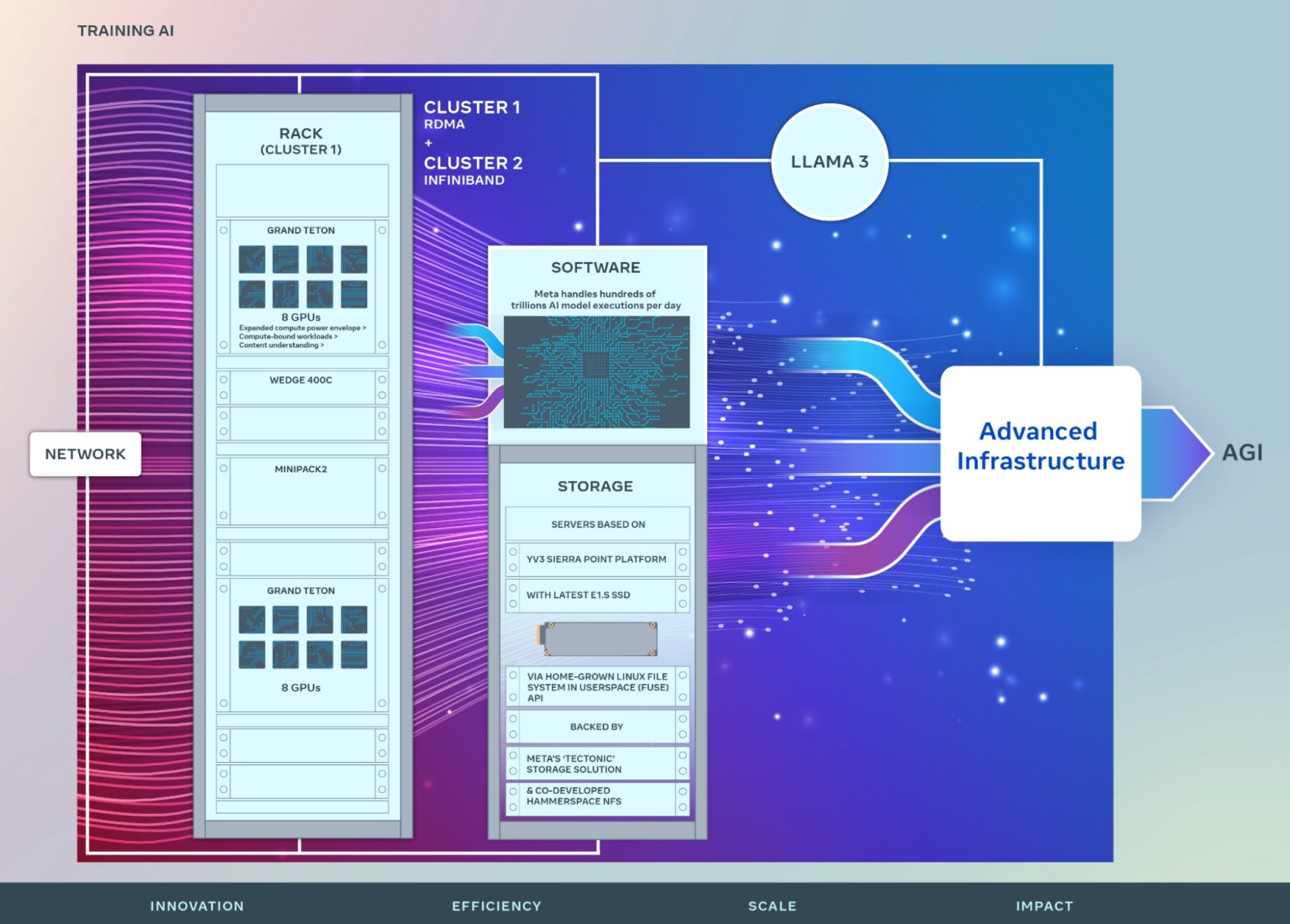

Per addestrare Llama 3, Meta utilizza cluster composti da oltre 24.500 GPU NVIDIA H100

In un approfondimento di recente pubblicazione, gli ingegneri di Meta hanno annunciato un investimento importante sul futuro dell’intelligenza artificiale, con la presentazione di due cluster composti da 24.576 GPU NVIDIA H100. Nel post, l’azienda fondata da Mark Zuckerberg rileva alcuni dettagli sull’hardware, la rete, lo storage, il design, le prestazioni e il software utilizzati per ottenere un’elevata affidabilità e throughput importanti per i carichi di lavoro più impegnativi, come appunto la fase di addestramento di Llama 3.

Sebbene costituisca una pietra miliare importante, il lancio di Llama 3 non è un punto d’arrivo. Meta fa sapere che entro fine 2024 l’azienda mira a continuare a espandere la propria infrastruttura, la quale includerà 350.000 GPU NVIDIA H100 come parte di un portafoglio che offrirà una potenza di calcolo equivalente a quasi 600.000 H100.

Verso lo sviluppo di un’AGI aperta e responsabile

I responsabili di Meta non ci girano intorno: tutta questa enorme potenza di calcolo mira a sviluppare, nel medio-lungo periodo, un’AGI, intelligenza artificiale generale.

Un’AGI, o intelligenza artificiale generale, mira a replicare l’intelligenza generale umana, in grado di comprendere, apprendere e risolvere una vasta gamma di compiti diversi in modo simile a un essere umano. A differenza delle intelligenze artificiali specializzate, che sono progettate per compiere specifiche attività o risolvere problemi ristretti, un’AGI dovrebbe essere in grado di adattarsi e apprendere nuovi compiti senza una riconfigurazione significativa. L’obiettivo è quello di far sì che la macchina possa affrontare una vasta gamma di compiti e problemi con la stessa flessibilità e creatività di un essere umano.

E se Meta si prepara a lavorare sullo sviluppo di un’AGI, la società sta cercando di scalare i suoi cluster per raggiungere l’ambizioso traguardo. Il viaggio verso l’AGI porta alla creazione di nuovi prodotti, nuove funzionalità e dispositivi informatici innovativi incentrati proprio sull’IA.

Per Meta, la sua AGI deve necessariamente essere aperta e costruita in modo responsabile, in modo da essere ampiamente disponibile e a beneficio di tutti. Un aspetto che Elon Musk, ad esempio, ha ripetutamente criticato a OpenAI, realtà che secondo il suo punto di vista avrebbe rinnegato le pattuizioni iniziali.

Supercluster di ricerca AI (RSC)

Meta ha una lunga storia di sviluppo dell’infrastruttura per le applicazioni di intelligenza artificiale. Nel 2022, il SuperCluster AI (RSC) formato da 16.000 GPU NVIDIA A100 ha permesso di accelerare la ricerca aperta e responsabile sull’IA, aiutando Meta nello sviluppo della prima generazione di modelli IA avanzati.

Quel “seme” gettato a suo tempo, ha rivestito un ruolo importante nello sviluppo di Llama e Llama 2, così come dei modelli di IA avanzati per le applicazioni di computer vision, NLP (elaborazione del linguaggio naturale) e riconoscimento vocale, generazione di immagini e codifica dei dati.

I nuovi cluster IA di Meta si basano sui successi e sulle lezioni apprese a partire dal SuperCluster RSC. L’obiettivo è infatti quello di spingere sulla costruzione di sistemi IA end-to-end, con un’enfasi particolare sull’esperienza e la produttività dei ricercatori e degli sviluppatori. L’efficienza delle reti ad alte prestazioni all’interno di questi cluster, alcuni scelte chiave in fatto di storage, l’utilizzo di oltre 24.500 GPU NVIDIA Tensor Core H100 in ciascun cluster, consentono di supportare modelli più grandi e complessi e aprono le porte allo sviluppo di innovative soluzioni GenAI.

Credit immagine in apertura: iStock.com – BlackJack3D

/https://www.ilsoftware.it/app/uploads/2024/03/llama-3-addestramento-modello-GPU-NVIDIA-H100.jpg)

/https://www.ilsoftware.it/app/uploads/2023/08/Conto-corrente.jpg)

/https://www.ilsoftware.it/app/uploads/2024/09/1-8.jpg)

/https://www.ilsoftware.it/app/uploads/2024/12/3-11.jpg)

/https://www.ilsoftware.it/app/uploads/2025/04/flux_image_475925_1745315889.jpeg)