/https://www.ilsoftware.it/app/uploads/2024/09/llama-32-LLM-RAG-visione-artificiale.jpg)

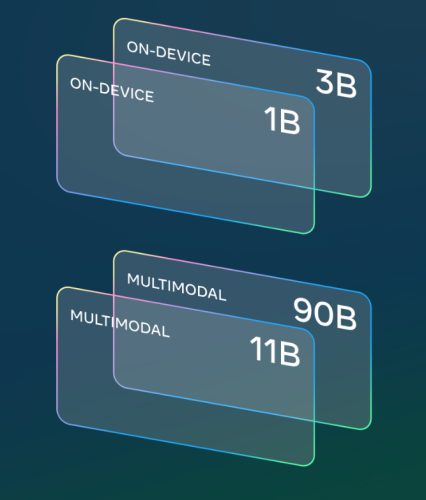

Meta ha rilasciato Llama 3.2, una nuova versione della sua serie di Large Language Models (LLM) basati su ben 11 miliardi (Llama 3.2 11B) e 90 miliardi di parametri (Llama 3.2 90B).

La principale novità dei modelli generativi appena svelati consiste nell’introduzione di capacità di “ragionamento” basate sulle immagini, superando modelli chiusi come Claude 3 Haiku. Senza rinnegare la natura aperta dei suoi LLM, gli ingegneri di Meta sottolineano che Llama 3.2 è personalizzabile usando strumenti come torchtune e torchchat.

Llama Stack, un insieme di distribuzioni semplificate per sviluppatori, è disponibile su piattaforme cloud, in ambito locale e sui dispositivi di ogni fattore di forma. Utilizzando il nuovo stack, i programmatori possono integrare facilmente funzioni avanzate ampliando la base di conoscenze dell’intelligenza artificiale mediante attività RAG.

RAG, acronimo di Retrieval-Augmented Generation, fa sì che i dati di addestramento del modello possano essere estesi con le informazioni di proprietà dell’azienda, senza effettuare trasferimenti di dati verso server remoti. Abbiamo detto come RAG aiuti a migliorare il business facendo in modo che l’intelligenza artificiale possa rispondere a prompt ben precisi utilizzando i dati conservati in azienda, magari frutto di anni di ricerca e sviluppo.

Llama 3.2: modelli che supportano il riconoscimento visivo e sono compatibili con i dispositivi mobili

Llama 3.2 11B e Llama 3.2 90B rappresentano un notevole balzo avanti rispetto ai precedenti LLM 7B e 70B. I parametri in un modello di apprendimento automatico sono i valori numerici che il modello apprende durante il processo di addestramento. Ogni parametro influenza il comportamento del modello e come esso elabora i dati in ingresso per fare previsioni o produrre output.

Il LLM Llama 3.2 11B ha 11 miliardi di variabili che possono essere ottimizzate durante l’addestramento per migliorare la precisione delle risposte. 90 miliardi di parametri suggerisce che si ha a che fare con un modello molto più grande e complesso, capace di elaborare informazioni più dettagliate e di fornire risposte più accurate o sofisticate, specialmente per compiti più complessi come la comprensione delle immagini o la generazione di testi avanzati. Tuttavia, modelli con più parametri richiedono anche più risorse di calcolo e memoria per funzionare, nella cosiddetta fase di inferenza.

I modelli Llama 3.2 supportano fino a 128K token, con riferimento alla quantità massima di token che il modello può elaborare in un singolo input o contesto. I token sono le unità di elaborazione del testo per i modelli di linguaggio. Un token può essere una parola, un frammento di parola o un simbolo, come abbiamo evidenziato nell’articolo citato in apertura.

La serie 11B e 90B nasce per svolgere compiti come la comprensione documentale e il riconoscimento visivo. I modelli partoriti nei laboratori Meta si comportano bene con l’analisi dei grafici, delle mappe e delle immagini, migliorando significativamente la capacità di estrarre informazioni complesse e generare descrizioni precise.

Qual è il vantaggio di poter lavorare con 128K token?

Grazie alla possibilità di gestire fino a 128K token, i modelli Llama 3.2 sono in grado di processare e “ricordare” informazioni molto più lunghe rispetto a modelli contraddistinti da una context window di dimensioni inferiori. Un aspetto cruciale nei compiti come la “comprensione” di documenti lunghi, conversazioni estese o la generazione di testi complessi che richiedono riferimenti a dati precedenti.

Llama 3.2 può quindi mantenere il contesto per periodi di tempo più lunghi, il che può migliorare la coerenza delle risposte, specialmente in scenari come il riepilogo di documenti lunghi o il mantenimento del filo logico in lunghe conversazioni. Quando ci si trova a dover elaborare grandi volumi di dati in un singolo passaggio, il supporto di una context window da 128K token si fa sentire.

Llama 3.2 anche nelle versioni leggere per smartphone e tablet

Meta ha reso disponibili non soltanto Llama 3.2 11B e Llama 3.2 90B, ma anche modelli leggeri 1B e 3B ottimizzati per l’edge e i dispositivi mobili. Capaci di funzionare su SoC Qualcomm e MediaTek, anche questi modelli gestiscono fino a 128K ed eccellono in compiti come la creazione di riassunti, la riscrittura di testi, la risposta a precise istruzioni.

I modelli 1B e 3B sono ideali per casi d’uso privati nei dispositivi edge (raccolgono, elaborano e analizzano dati direttamente vicino alla fonte, senza inviarli immediatamente a server o data center centrali). In queste situazioni applicative, i dati rimangono sul dispositivo, garantendo velocità e sicurezza, senza la necessità di trasferire informazioni sul cloud.

/https://www.ilsoftware.it/app/uploads/2025/04/SoC-intel-automotive.jpg)

/https://www.ilsoftware.it/app/uploads/2023/07/Adobe-Firefly-logo-IA-generativa-immagini-min.jpg)

/https://www.ilsoftware.it/app/uploads/2025/04/rayban-meta-occhiali-smart.jpg)

/https://www.ilsoftware.it/app/uploads/2023/08/YouTube-Logo.png)