/https://www.ilsoftware.it/app/uploads/2024/04/jetmoe-LLM-aperto.jpg)

Nel panorama delle applicazioni per l’intelligenza artificiale, è sempre più evidente l’importanza dei Large Language Models (LLM) per il miglioramento e l’ottimizzazione delle applicazioni linguistiche e della comprensione del linguaggio naturale. Di recente, un nuovo protagonista ha fatto il suo ingresso sul palcoscenico: si tratta del modello JetMoE-8B.

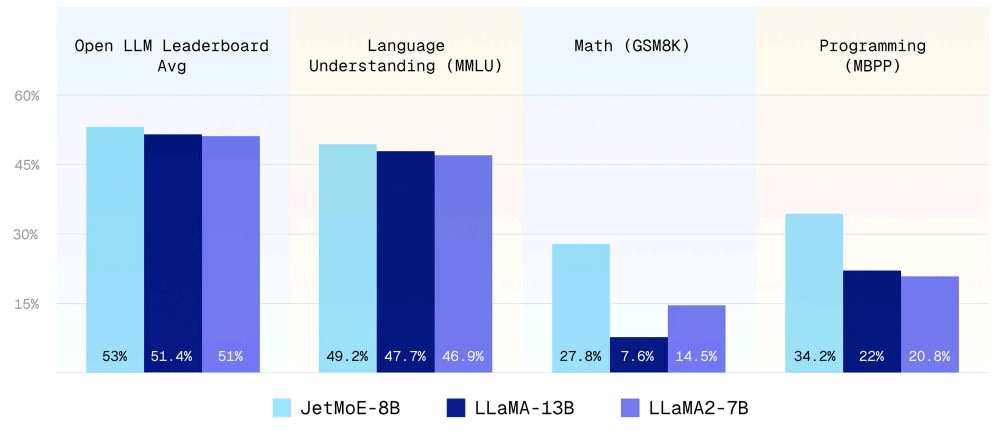

Sviluppato dagli esperti di MyShell, JetMoE-8B si mette in evidenza per le sue prestazioni eccezionali, che superano di gran lunga quelle dei modelli esistenti, come il noto e apprezzato Llama 2-7B di Meta. Ciò che rende JetMoE-8B ancora più straordinario è il fatto che riesce a raggiungere livelli prestazionali di primo livello a fronte di costi di addestramento nettamente inferiori.

LLM: JetMoE-8B dimostra che l’intelligenza artificiale non deve essere costosa

I tecnici di MyShell spiegano che JetMoE-8B ha seguito una procedura di addestramento usando solo set di dati pubblici, facilitando il suo utilizzo in una vasta gamma di applicazioni e democratizzando l’accesso alle soluzioni di intelligenza artificiale.

JetMoE-8B sa esprimere prestazioni paragonabili o addirittura superiori a modelli come Llama 2-7B, DeepseekMoE-16B e Gemma-2B. Un elemento chiave che ha catturato l’attenzione degli esperti è il costo di addestramento di JetMoE-8B, notevolmente inferiore rispetto a quello dei modelli concorrenti. Nonostante l’investimento pari a meno di 100.000 dollari, JetMoE-8B riesce a mettersi in evidenza, per la qualità degli output prodotti, rispetto a modelli con risorse di addestramento multi-milionarie.

Un risultato che solleva importanti considerazioni sul costo effettivo dell’addestramento dei modelli linguistici, dimostrando che la creazione di modelli efficaci e performanti può essere molto più conveniente di quanto generalmente si pensi.

La struttura del modello

JetMoE-8B è costituito da 24 blocchi, ognuno dei quali contiene due strati Mixture of Attention heads (MoA) e Mixture of MLP Experts (MoE). Ogni strato MoA e MoE è composto da 8 “esperti”, di cui 2 sono attivati per ogni token in input. Il modello utilizza complessivamente 8 miliardi di parametri, di cui 2,2 miliardi sono attivi nella fase di inferenza.

L’approccio MoA sfrutta il meccanismo di attenzione, alla base del concetto di Transformer, proposto nel 2017 da Google e “padre” di tutti i LLM moderni. L’attenzione è un aspetto chiave nei modelli di lingua che consente di concentrarsi su parti specifiche dell’input durante il processo di elaborazione. MoE, invece, si riferisce a uno schema che prevede l’uso di una rete neurale separata, in cui ogni “esperto” è specializzato nel compito di risolvere un aspetto specifico del problema di elaborazione del linguaggio.

Durante l’inferenza, solo un sottoinsieme degli esperti è attivato in base all’input specifico, contribuendo a rendere il processo computazionalmente efficiente.

Come provare il modello JetMoE-8B

Per coloro che desiderano sperimentare direttamente le capacità di JetMoE-8B, è possibile accedere al sito dimostrativo Lepton AI. Qui è possibile interagire con un’interfaccia che dà modo di lavorare con il rivoluzionario LLM di MyShell.

Grazie alla piattaforma Lepton AI, gli sviluppatori possono testare le capacità di JetMoE-8B ed esplorare le sue possibilità in vari contesti.

Previa effettuazione del login, gli sviluppatori possono ottenere un token personale per accedere tramite API a Lepton AI e al sottostante modello JetMoE-8B. Nel riquadro a destra, è riportato il codice Python, JavaScript e la sintassi HTTP (utilizzabile ad esempio con un comando curl) per interagire con il modello generativo tramite le proprie applicazioni.

Il lancio di JetMoE-8B segna una svolta significativa nel campo dell’intelligenza artificiale, offrendo prestazioni eccezionali a fronte di costi ridotti. Con il suo approccio all’avanguardia e la sua accessibilità, il modello promette di rivoluzionare l’uso e lo sviluppo di applicazioni basate sul linguaggio naturale, aprendo nuove opportunità per l’innovazione e l’avanzamento tecnologico.

Credit immagine in apertura: iStock.com – Vertigo3d

/https://www.ilsoftware.it/app/uploads/2025/01/1-25.jpg)

/https://www.ilsoftware.it/app/uploads/2023/08/Conto-corrente.jpg)

/https://www.ilsoftware.it/app/uploads/2024/09/1-8.jpg)

/https://www.ilsoftware.it/app/uploads/2024/12/3-11.jpg)