Dopo aver destato forti preoccupazioni circa la sostenibilità delle soluzioni occidentali basate sull’intelligenza artificiale, la cinese DeepSeek torna all’attacco pubblicando su HuggingFace il suo nuovo modello Janus-Pro, capace di creare immagini realistiche a partire da prompt testuali. Il modello appena svelato mostra significativi progressi sia nella comprensione multimodale che nella generazione di immagini basata su istruzioni testuali, migliorando al contempo la stabilità nella creazione dei contenuti visuali. Il repository GitHub contiene codice e modelli, da oggi a disposizione di tutti gli interessati.

Cos’è Janus-Pro e come migliora la creazione di immagini con l’intelligenza artificiale

Janus-Pro utilizza un’architettura che disaccoppia la codifica visiva per le attività di comprensione multimodale e generazione visuale. La struttura messa a punto dai tecnici di DeepSeek prevede due encoder distinti: uno per la comprensione (Understanding Encoder) e uno per la generazione (Generation Encoder). I dati sono elaborati tramite un “trasformatore autoregressivo unificato”, che consente di gestire in modo efficiente le informazioni provenienti da diverse modalità (testo e immagini).

Il trasformatore autoregressivo unificato è un modello di intelligenza artificiale progettato per gestire simultaneamente compiti di comprensione e generazione multimodale, lavorando su testi e immagini. Questo tipo di architettura utilizza appunto un approccio autoregressivo, in cui il modello genera output sequenzialmente, predicendo ogni elemento successivo in base agli elementi precedenti.

Il nuovo modello di DeepSeek migliora la sua strategia di addestramento utilizzando un maggiore numero di passi di addestramento per consentire una modellazione efficace della dipendenza tra pixel. Si astiene inoltre dall’uso dei dati di ImageNet (vasto database di immagini etichettate, utilizzato per addestrare algoritmi di intelligenza artificiale nel riconoscimento delle immagini), concentrandosi direttamente sui dati testuali al fine di generare immagini basate su descrizioni dettagliate.

Performance, stabilità e qualità visiva

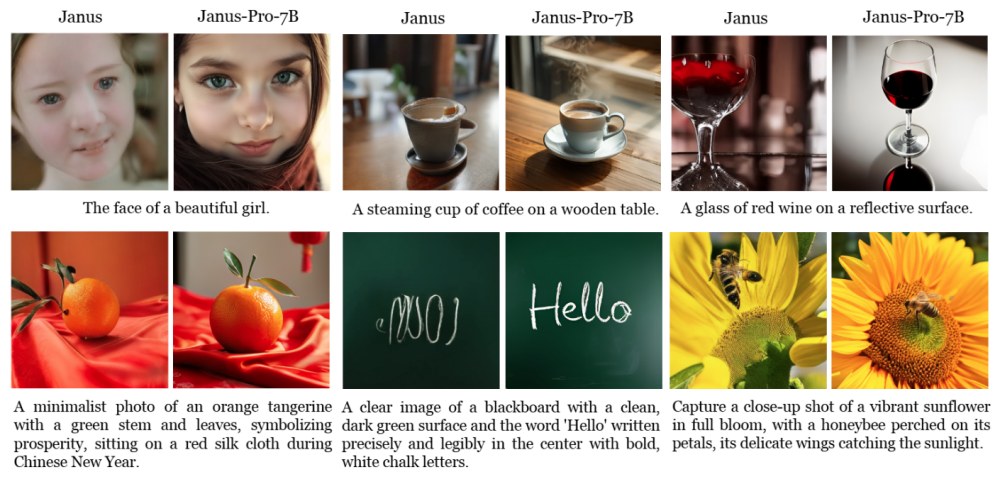

Janus-Pro ha mostrato risultati superiori rispetto a modelli precedenti e concorrenti in vari benchmark. Ad esempio, sul piano della comprensione multimodale riesce a superare modelli come TokenFlow e MetaMorph. Sul versante della generazione testo-immagine, ha sorpassato rivali come DALL-E 3 e Stable Diffusion 3 Medium.

La soluzione appena svelata da DeepSeek, inoltre, assicura una generazione di immagini più stabile e dettagliata, anche con prompt brevi. La qualità visiva appare davvero elevata, consentendo anche la generazione di testi semplici da inserire automaticamente nelle immagini. Aspetto, questo, attualmente introvabile nelle proposte della concorrenza.

Nel complesso, Janus-Pro non solo migliora le abilità già note per i principali modelli AI, ma stabilisce anche nuovi standard nel campo della comprensione multimodale e della generazione visiva.

Come provare Janus-Pro

Provate a fare qualche test utilizzando la demo di Janus-Pro su Hugging Face. La prima parte della pagina permette di sottoporre all’AI un’immagine quindi porre un quesito sul suo contenuto (Question). Nella seconda parte vi è invece la possibilità di avviare la generazione di un’immagine a partire da un prompt testuale.

A questo indirizzo trovate invece in codice Python per eseguire il modello in locale e disporre sia attività di comprensione multimodale che servirsi della generazione di immagini di qualità.

I parametri CFG Weight, Temperature e top_p

Come si vede nella demo ospitata su HuggingFace, Janus-Pro utilizza alcuni parametri per la generazione delle immagini.

In particolare CFG Weight (Classifer-Free Guidance Weight) è un peso che determina quanto il modello si attenga a una guida specifica (i.e. il prompt testuale) rispetto alla sua creatività intrinseca. Un valore più alto di CFG Weight implica che il modello segue più rigidamente le istruzioni fornite, mentre un valore più basso consente una maggiore libertà creativa, portando a risultati più variabili.

Temperature è un parametro che controlla la casualità delle scelte del modello durante la generazione. Un valore di temperatura basso (vicino a 0) rende il modello più deterministico, producendo output più coerenti e prevedibili. Al contrario, una temperatura alta (ad esempio, pari o superiore a 1) introduce maggiore casualità, permettendo al modello di esplorare soluzioni più diverse e creative, ma anche meno coerenti.

Infine, il parametro top_p è una tecnica utilizzata al fine di controllare la diversità degli output. Invece di considerare solo le parole più probabili (come avviene nel campionamento basato sulla temperatura), top_p seleziona un insieme dinamico di parole candidate in base a una probabilità cumulativa. È un metodo efficace per bilanciare creatività e coerenza, adattando dinamicamente l’ampiezza del campionamento in base alla distribuzione delle probabilità delle parole.

/https://www.ilsoftware.it/app/uploads/2025/01/deepseek-janus-pro-generazione-immagini-AI.jpg)

/https://www.ilsoftware.it/app/uploads/2025/04/SoC-intel-automotive.jpg)

/https://www.ilsoftware.it/app/uploads/2023/07/Adobe-Firefly-logo-IA-generativa-immagini-min.jpg)

/https://www.ilsoftware.it/app/uploads/2025/04/rayban-meta-occhiali-smart.jpg)

/https://www.ilsoftware.it/app/uploads/2023/08/YouTube-Logo.png)