Era il 2022 quando un team di esperti Google Research, coadiuvati dagli accademici dell’Università di Tokyo presentarono il loro studio “Large Language Models are Zero-Shot Reasoners”. Si tratta di un documento che introduceva un’idea innovativa, recentemente sviluppata da OpenAI e da altri fornitori di soluzioni AI. L’approccio chain-of-thought, traducibile in italiano come “catena di ragionamento” o “concatenazione di pensieri”, introduce di fatto le abilità di ragionamento nei modelli di intelligenza artificiale generativa.

Lo schema Zero-shot-CoT (ossia Zero-shot chain-of-thought), individuato a suo tempo da Google, utilizza una semplice frase di attivazione come “Let’s think step by step” per esortare il modello a scomporre un problema in più passaggi, senza partire da alcun esempio fornito in precedenza. L’obiettivo è portare l’AI ad affrontare i problemi logico-matematici (in precedenza, vero e proprio tallone d’Achille di qualunque modello) in maniera molto simile a quanto farebbe un essere umano.

Google introduce il ragionamento nel suo modello Gemini 2.0 Flash Thinking

Accanto alle altre versioni del nuovo modello Gemini 2.0, presentato nei giorni scorsi, Google ha appena tolto il velo da una nuova versione che integra abilità di reasoning. Gemini 2.0 Flash Thinking è infatti progettato per generare processi di pensiero articolati. Il sistema è concepito per fornire risposte rapide, ma con un livello di profondità logica che supera persino i modelli più avanzati disponibili oggigiorno.

A differenza di OpenAI, che ha optato per il massimo riserbo sui “ragionamenti” effettuati dai suoi modelli GPT-o1, Google permette agli utenti di visualizzare i passaggi che hanno portato a sviluppare le soluzioni restituite all’utente.

Il nuovo modello generativo Google sul banco di prova

Un esempio emblematico è presentato da Noam Shazeer, figura chiave del progetto Gemini. Shazeer ha sottoposto a Gemini 2.0 Flash Thinking il seguente quesito:

Se continuo a lanciare una moneta finché non ottengo TTT o TCT (dove “T” sta per testa e “C” sta per croce), qual è il rapporto di probabilità tra le due combinazioni?

Per il calcolo delle probabilità, il modello ha generato un “ragionamento” passo-passo, fornendo la risposta corretta (2:3) in circa 30 secondi. Il risultato dimostra come il modello non si limiti a dare risposte, ma si impegni a strutturare una logica dietro di esse.

Posto lo stesso quesito a GPT-o1, anche il modello di OpenAI è riuscito a pervenire alla medesima (corretta) conclusione, impegnando qualche secondo in più. In un altro articolo abbiamo fornito alcuni spunti per far ragionare ChatGPT con il modello o1: gli stessi esempi possono essere utilizzati nel caso di Gemini 2.0 Flash Thinking.

Un altro test interessante è quello di Logan Kilpatrick, responsabile di Google AI Studio. Ha mostrato al modello un enigma visivo con quattro palle da biliardo numerate “7”, “9”, “11” e “13”.

L’obiettivo era trovare una combinazione di tre numeri che, sommati, dessero 30 come risultato. Dopo aver calcolato tutte le combinazioni possibili e non aver trovato una soluzione, il modello ha ipotizzato un cambio di prospettiva: “e se i numeri fossero interpretati diversamente? Se il numero 9 fosse ruotato, potrebbe diventare un 6”. Con questo approccio, il modello ha individuato la soluzione corretta, ovvero 6, 11 e 13.

Un’ulteriore conferma di come Gemini 2.0 Flash Thinking sia in grado di affrontare problemi non lineari e di utilizzare un approccio creativo e strategico per arrivare alla risposta corretta.

Come provare Gemini 2.0 Flash Thinking

Chi volesse effettuare in proprio dei test approfonditi sul comportamento di Gemini 2.0 Flash Thinking, può già farlo accedendo alla piattaforma Google AI Studio. Agendo sul menu a tendina Model, posto nella colonna di destra, si ha la possibilità di scegliere il modello di Google che utilizza il reasoning e iniziare a porgli subito delle domande complesse.

Con un clic su Expand to view model thoughts, è possibile verificare in tempo reale quali ragionamenti sta sviluppando Gemini 2.0 Flash Thinking, seguendone l’intero flusso.

Gli sviluppatori possono accedere a Gemini 2.0 Flash Thinking anche da prompt dei comandi con curl oppure utilizzando linguaggi di programmazione come Python e JavaScript.

Abbiamo visto come parlare con Gemini 2.0 dalle proprie app Python via API. Ecco, le stesse API (Application Programming Interface) possono essere sfruttate per dialogare anche con Gemini 2.0 Flash Thinking. La sintassi da usare è riportata in questa pagina di supporto: bisogna soltanto avere l’accortezza di chiamare il modello gemini-2.0-flash-thinking-exp (“exp” significa che Gemini 2.0 Flash Thinking è ancora da considerarsi come in fase sperimentale).

Il test che abbiamo fatto

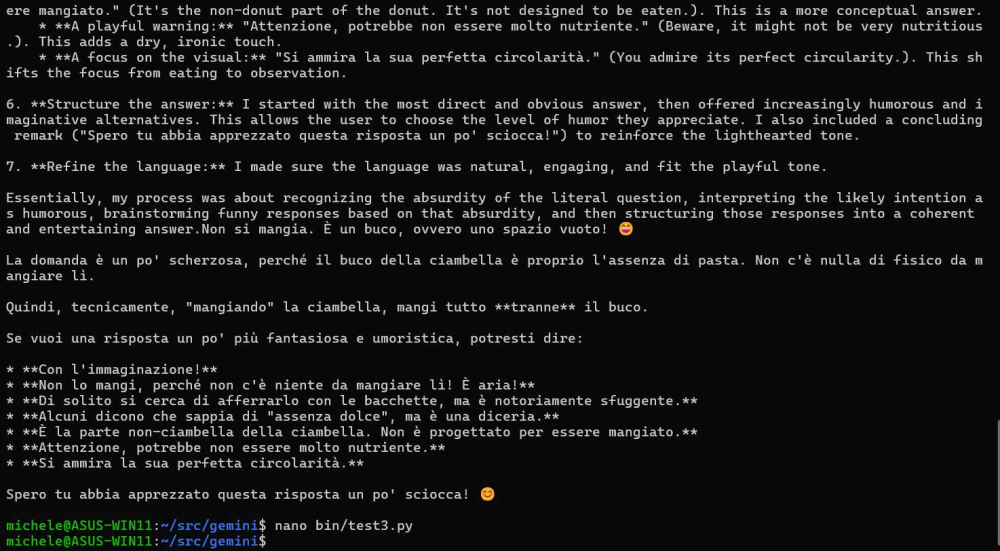

Utilizzando il seguente semplice script Python (che potete eventualmente riciclare anche voi…) abbiamo chiesto a Gemini 2.0 Flash Thinking di “riflettere” e rispondere alla domanda “Come si mangia il buco di una ciambella?”:

from google import genai

client = genai.Client(

api_key="CHIAVE_API"

)

response = client.models.generate_content(

model="gemini-2.0-flash-thinking-exp", contents="Come si mangia il buco di una ciambella?"

)

print(response.text)

Guardate il tenore delle risposte fornite dal modello. Alcune sono davvero ironiche, tutte assolutamente pertinenti e ben argomentate:

La domanda è un po’ scherzosa, perché il buco della ciambella è proprio l’assenza di pasta. Non c’è nulla di fisico da mangiare lì.

Quindi, tecnicamente, “mangiando” la ciambella, mangi tutto *tranne* il buco.

Se vuoi una risposta un po’ più fantasiosa e umoristica, potresti dire:

- Con l’immaginazione!

- Non lo mangi, perché non c’è niente da mangiare lì! È aria!

- Di solito si cerca di afferrarlo con le bacchette, ma è notoriamente sfuggente.

- Alcuni dicono che sappia di “assenza dolce”, ma è una diceria.

- È la parte non-ciambella della ciambella. Non è progettato per essere mangiato.

- Attenzione, potrebbe non essere molto nutriente.

- Si ammira la sua perfetta circolarità.

Prestazioni straordinarie

La capacità di combinare velocità e profondità ha permesso al modello di primeggiare nella Chatbot Arena, una piattaforma di test comparativi in cui gli utenti valutano le prestazioni dei modelli AI senza conoscerne l’identità a priori.

Gemini 2.0 Flash Thinking si è classificato primo, superando concorrenti di alto livello come OpenAI o1-preview e GPT-4o, consolidando la sua posizione come uno dei modelli più avanzati sul mercato.

Con Gemini 2.0 Flash Thinking, insomma, Google non solo innalza gli standard nel campo dell’AI, ma introduce un paradigma completamente nuovo nella generazione di risposte. La combinazione di velocità, creatività e ragionamento strategico rende questo modello uno strumento indispensabile per applicazioni che richiedono decisioni rapide e intelligenti.

/https://www.ilsoftware.it/app/uploads/2024/12/gemini-20-flash-thinking-ragionamento-IA.jpg)

/https://www.ilsoftware.it/app/uploads/2025/04/comandi-ai-tag-gestire-schede-browser.jpg)

/https://www.ilsoftware.it/app/uploads/2024/12/3-11.jpg)

/https://www.ilsoftware.it/app/uploads/2025/04/whatsapp-automazione-claude-AI.jpg)

/https://www.ilsoftware.it/app/uploads/2025/04/vulnerabilita-bootloader-AI.jpg)