Un crawler è un software che effettua la scansione del contenuto delle pagine web seguendo i link ipertestuali ivi presenti (il ben noto tag anchor) e raccogliendo quante più informazioni possibile.

I motori di ricerca generalmente usano più crawler per scandagliare il Web in profondità. Google, ad esempio, usa due crawler, uno per simulare l’accesso ai siti web da desktop, l’altro da un dispositivo mobile. In futuro il crawler desktop è destinato a scomparire con l’attenzione che Google, specie da marzo 2021, ha intenzione di riservare alla consultazione da dispositivo mobile.

Il crawler ha solamente il (gravoso) compito di seguire i link presenti nelle pagine: l’eventuale indicizzazione di un contenuto nel motore di ricerca è un’operazione che viene condotta in seconda battuta. Essa implica infatti l’utilizzo di un complesso algoritmo di ranking che valuta il contenuto sottoposto a scansione in precedenza, effettua una valutazione circa la sua autorevolezza e ne decide il posizionamento nelle SERP oppure nelle pagine dei risultati, proposti dal motore di ricerca, in seguito all’inserimento di una particolare query.

Chi amministra uno o più siti web sa benissimo quanto sia preziosa la Search Console di Google che offre informazioni sullo stato delle pagine all’interno del motore di ricerca.

I crawler di Google non sono soltanto due: l’azienda di Mountain View ne utilizza degli altri, in molti casi uno per ciascun servizio gestito dall’azienda. La lista dei crawler Google è pubblicata qui.

Ogni volta che un crawler Google raggiunge una pagina web, esso si presenta con uno specifico user agent ovvero con una stringa che ne attesta l’identità.

La stringa user agent viene trasmessa anche dal browser che state utilizzando in questo momento e ogni browser ne utilizza una “ad hoc”, diversa dagli altri. Anzi, lo user agent cambia a seconda della release del browser installata, dei componenti utilizzati in locale e della versione del sistema operativo in uso.

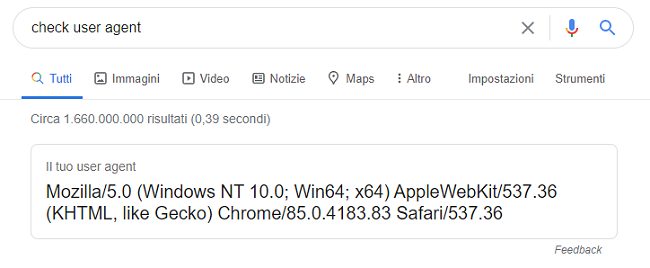

Per scoprire la vostra stringa user agent basta che digitiate check user agent nella casella di ricerca di Google.

Google ha fatto presente che Chrome accantonerà l’utilizzo della stringa user agent ma i suoi Googlebot continueranno a trasmettere il loro user agent.

Verificare come appare una pagina web a Googlebot

Google fornisce alcuni strumenti per verificare come appare una pagina web agli “occhi” dei suoi crawler.

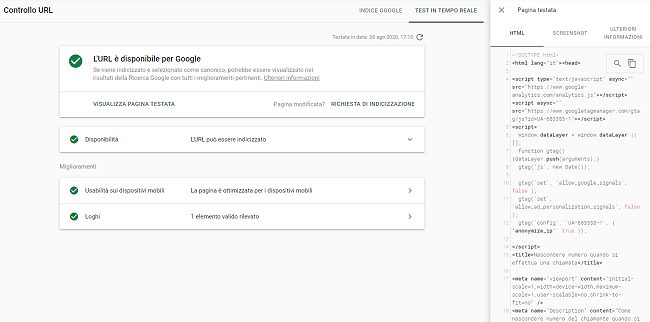

Uno di essi si chiama Controllo URL ed è integrato nella Search Console.

Incollando l’URL della pagina da verificare nell’apposita casella quindi cliccando su Visualizza pagina sottoposta a scansione, si accederà al codice che visualizza la scansione di Googlebot. L’accesso a queste informazioni è tuttavia possibile solo per le pagine che sono state aggiunte all’indice di Google ovvero che sono pubblicate sul motore di ricerca (pulsante Testa URL pubblicato).

Proprio modificando la stringa user agent del browser è però possibile simulare l’accesso da parte di Googlebot su qualunque pagina web.

Posto che la procedura è applicabile con qualunque browser web (vedere Come cambiare user agent con i principali browser web), per simulare l’accesso a una pagina da Googlebot con Chrome è sufficiente procedere come segue.

Ci si accorgerà di quali e quanti siti web presentano contenuti differenti a seconda del client e si potrà controllare che si comportano le proprie pagine.

1) Visitare la pagina con l’elenco delle stringhe user agent usate dai Googlebot quindi copiare e incollare altrove quella di Googlebot (Desktop) o Googlebot (smartphone).

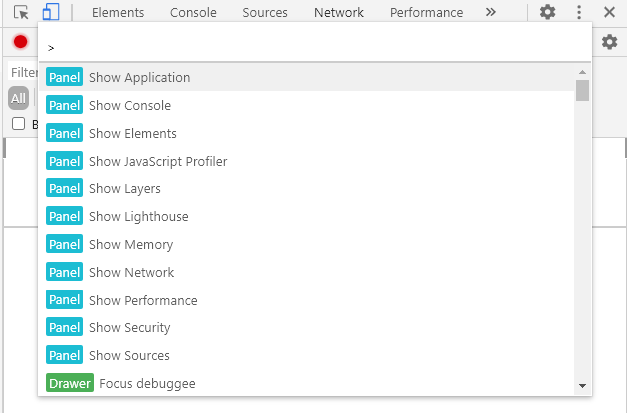

2) Avviare Google Chrome e premere il tasto F12 per accedere agli Strumenti per gli sviluppatori. Prima di usare il tasto F12 potrebbe essere utile aprire una finestra di navigazione in incognito in modo da essere svincolati, per esempio, da qualunque cookie impostato sul sistema: Navigazione in incognito, quando utilizzarla?.

3) Premere la combinazione di tasti CTRL+MAIUSC+P per far apparire la casella di ricerca riprodotta in figura.

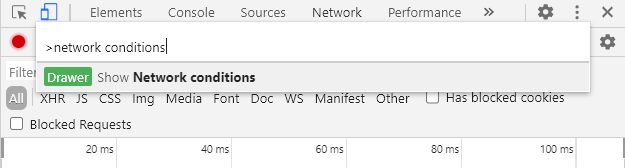

4) Digitare network conditions quindi cliccare sulla voce Show network conditions.

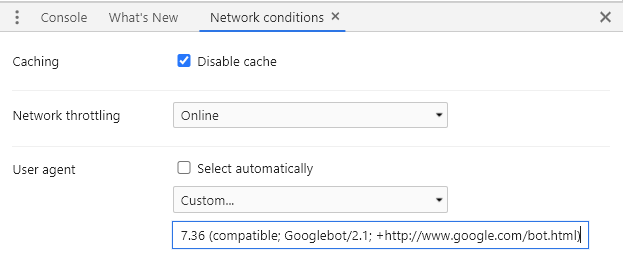

5) Nella scheda Network conditions disattivare la casella Select automatically, selezionare Custom nel sottostante menu a tendina quindi incollare la stringa user agent di Googlebot.

6) Digitando check user agent nella casella di ricerca di Google si vedrà apparire lo user agent di Googlebot.

7) Visitando una qualunque pagina web si simulerà una visita da parte di Googlebot e si potrà verificare come apparirà “agli occhi” del crawler Google.

8) Per annullare la modifica, basterà chiudere gli Strumenti per gli sviluppatori di Chrome.

/https://www.ilsoftware.it/app/uploads/2023/05/img_21736.jpg)

/https://www.ilsoftware.it/app/uploads/2025/04/codex-cli-openai-cos-e-come-funziona.jpg)

/https://www.ilsoftware.it/app/uploads/2025/04/compleanno-git-20-anni-linus-torvalds.jpg)

/https://www.ilsoftware.it/app/uploads/2025/04/sorgente-altair-basic.jpg)

/https://www.ilsoftware.it/app/uploads/2025/04/whatsapp-automazione-claude-AI.jpg)