Gemini 2.0 è l’ultima evoluzione del modello di intelligenza artificiale sviluppato da Google, lanciato l’11 dicembre 2024. Rappresenta un significativo passo avanti nel campo dell’intelligenza artificiale (AI), introducendo funzionalità avanzate che mirano a trasformare l’interazione uomo-macchina. Non è infatti un “semplice” LLM (Large Language Model) bensì un sistema avanzato che indossa i panni di agente AI, capace di comprendere il contesto e anticipare le necessità degli utenti. Il bello è che Google permette l’uso gratuito di Gemini 2.0, offrendo la possibilità di interfacciarlo con le proprie applicazioni. In questo articolo vediamo ad esempio come parlare con Gemini 2.0 da un’app Python, usando le API (Application Programming Interface) di Google.

Gemini 2.0 e l’architettura multimodale

Una delle innovazioni più significative di Gemini 2.0 consiste nella sua architettura multimodale nativa. Il modello può elaborare e generare contenuti in diverse forme: testo, immagini, video e audio. Questa capacità di gestire input e output multimodali offre nuove opportunità per sviluppatori e utenti, rendendo le applicazioni più interattive e sofisticate.

Pur mantenendosi strettamente legato alla supervisione umana, Gemini 2.0 può agire anche in modo autonomo. È inoltre in grado di gestire compiti complessi, come pianificare appuntamenti o interagire con altri sistemi automatizzati.

Gemini 2.0 sarà progressivamente integrato nei servizi Google esistenti, migliorando la gestione di query complesse e aumentando l’efficienza generale nell’interazione con gli utenti.

Come interagire con Gemini 2.0 usando API gratuite

Uno dei principali vantaggi di Gemini 2.0 è che, a differenza delle principali soluzioni della concorrenza (OpenAI, cough, cough…), le API che permettono di interagire con il modello sono completamente gratuite. Fantastico! Ciò significa che qualunque applicazione si sviluppi in proprio, essa può arricchirsi delle funzionalità di intelligenza artificiale generativa a costo zero.

Immaginate un dispositivo indipendente e compatto, con una scarsa potenza computazionale: con poche righe di codice può diventare in grado di rispondere a qualunque quesito posto in linguaggio naturale appoggiandosi alle risorse cloud offerte da Gemini 2.0.

Prendiamo ad esempio una Raspberry Pi 5 (ma si potrebbe usare qualunque altro dispositivo) e sviluppiamo poche righe di codice Python per parlare con Gemini 2.0.

Cos’è Gemini 2.0 Flash

Insieme con la versione principale, Google ha lanciato anche Gemini 2.0 Flash. Si tratta di una versione che ambisce a diventare il punto di riferimento, bilanciando qualità delle risposte e performance.

Gemini 2.0 Flash è progettato per essere significativamente più veloce, raddoppiando le prestazioni rispetto al suo predecessore, Gemini 1.5 Pro. Questa maggiore velocità lo rende ideale per applicazioni che richiedono risposte rapide, come assistenti virtuali e chatbot.

Anche la versione Flash di Gemini 2.0 può gestire output multimodali in modo nativo, consentendo la generazione di contenuti visivi e vocali in modo integrato. Così, l’esperienza d’uso può diventare davvero ricca e interattiva.

Il modello può inoltre richiamare funzioni native come la Ricerca Google, eseguire codice e interagire con strumenti di terze parti, ampliando notevolmente il livello di automazione e le funzionalità disponibili per gli sviluppatori.

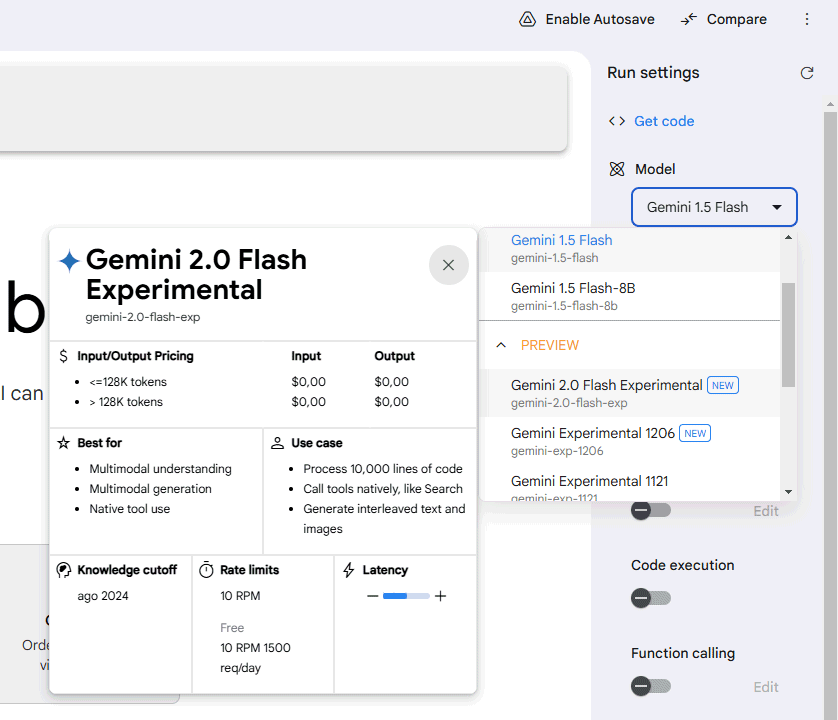

Come provare il modello

Prima di mettere mano al codice di programmazione, suggeriamo di aprire Google AI Studio quindi scegliere Gemini 2.0 Flash Experimental dalla colonna a destra (Model).

Come potete immediatamente verificare, a parte qualche restrizioni sul numero di richieste per minuto (RPM) e su quelle giornaliere, l’utilizzo di Gemini 2.0 Flash è da considerarsi del tutto gratuito.

Provate adesso a digitare, nella casella Type something una richiesta che ha a che fare con i risultati conseguiti, ad esempio, da una squadra di calcio. Vedrete che Gemini 2.0 vi fornirà una risposta non attuale, ad esempio il risultato di una partita disputata diversi mesi fa. Questo perché i LLM sono addestrati utilizzando una vasta mole di informazioni passate in input. L’addestramento, tuttavia, permette di sviluppare una base di conoscenze che poi resta ferma a una data specifica.

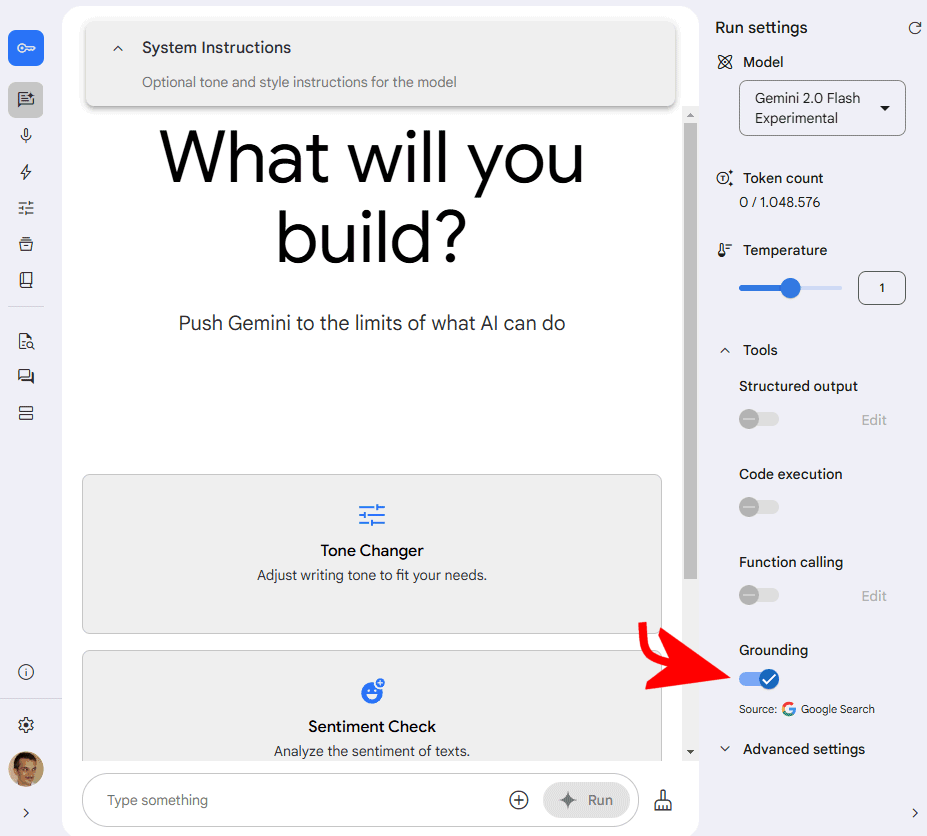

Il Grounding, per sbloccare le conoscenze sull’attualità

La funzionalità Grounding di Gemini 2.0 aiuta a generare risposte più accurate e contestualizzate. In particolare, consente ai modelli Gemini di integrare dati aggiornati direttamente dalla Ricerca Google.

L’approccio permette di fornire risposte basate su informazioni verificate e in tempo reale, migliorando così la qualità e la precisione delle risposte. A differenza dei tradizionali motori di ricerca, che restituiscono risultati basati su query statiche, la funzionalità di grounding utilizza l’intelligenza artificiale per comprendere il significato e l’intento del prompt.

Provate adesso ad attivare l’opzione Grouding, nella colonna a destra, e ripetete la stessa domanda (prompt) a Gemini 2.0 Flash: vedrete che il modello si avvarrà adesso anche di una o più fonti tratte dal Web per fornire una risposta puntuale e, soprattutto, molto più aggiornata.

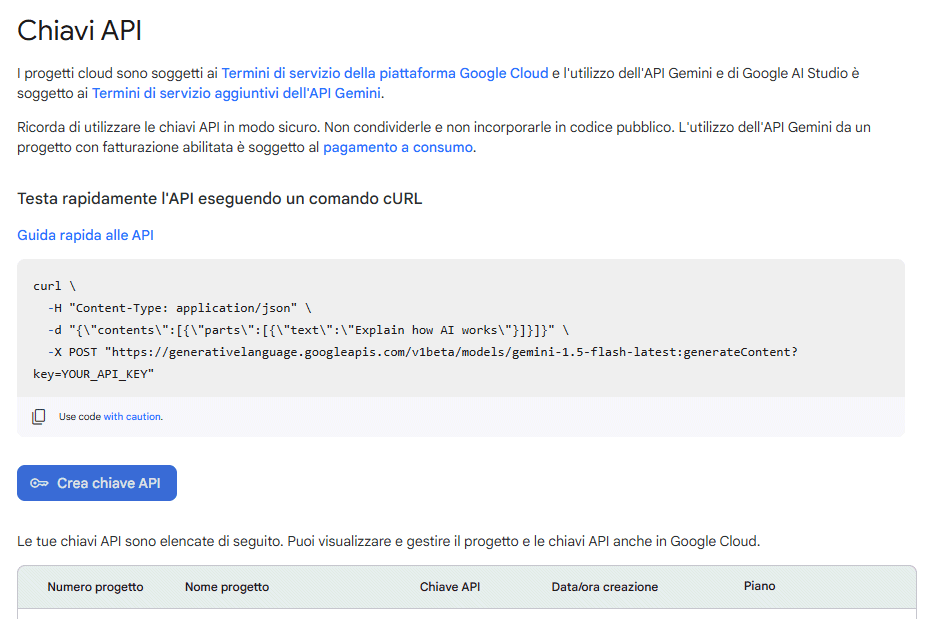

Generare una chiave API

La prima cosa da fare per iniziare a dialogare con Gemini 2.0 consiste nella generazione di un’API key. Per procedere in tal senso, basta fare riferimento alla piattaforma Google AI Studio quindi cliccare sul pulsante Get API key in alto a sinistra. Ancora, con un clic su Crea chiave API, si ottiene una lunga stringa alfanumerica che deve essere copiata e salvata: ci servirà tra poco.

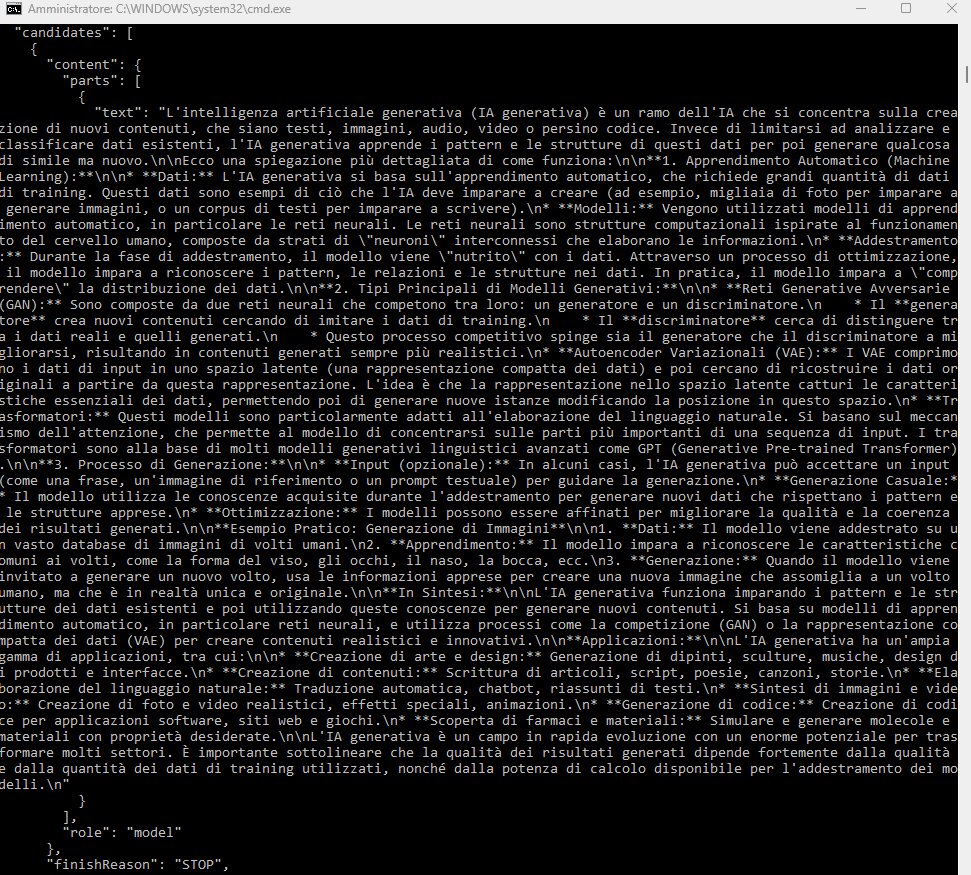

Un test con curl

Adesso che avete acquisito la vostra API key gratuita, potete utilizzare l’utilità curl (disponibile anche su Windows) per dialogare con Gemini 2.0. Aprendo la finestra del terminale e digitando quanto segue (sostituite CHIAVE_API con quella vostra), vedrete che Gemini 2.0 Flash fornirà istantaneamente una risposta al quesito indicato (liberamente personalizzabile):

curl -H "Content-Type: application/json" -d "{\"contents\":[{\"parts\":[{\"text\":\"Spiega come funziona l'intelligenza artificiale generativa\"}]}]}" -X POST "https://generativelanguage.googleapis.com/v1beta/models/gemini-2.0-flash-exp:generateContent?key=CHIAVE_API"

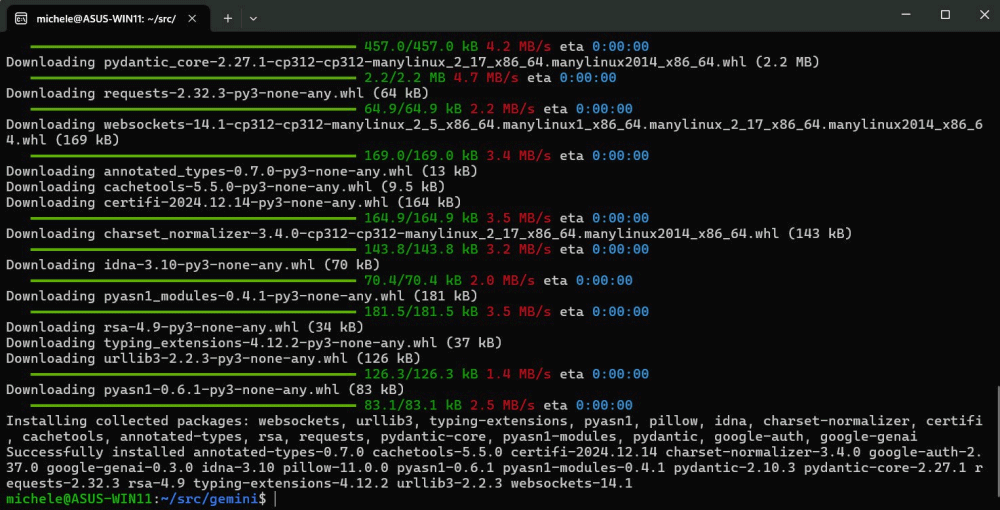

Preparazione dei requisiti software

Supponendo di trovarci nella finestra del terminale Linux, ad esempio su una Raspberry Pi, oppure su qualunque altro dispositivo, procediamo con l’installazione di tutto il necessario per parlare con Gemini 2.0 usando le API Google:

sudo apt install python3 -y

sudo apt install python3.12-venv -y

python3 -m venv src/gemini

cd src/gemini

bin/pip install google-genai

Il primo comando installa il pacchetto python3 dal repository di sistema; il secondo predispone il modulo venv specifico per Python 3.12, necessario per creare ambienti virtuali isolati.

Successivamente, si possa alla creazione di un nuovo ambiente virtuale nella directory src/gemini. L’ultimo comando utilizza il gestore di pacchetti pip per installare la libreria google-genai necessaria per interagire tramite API con i LLM Google.

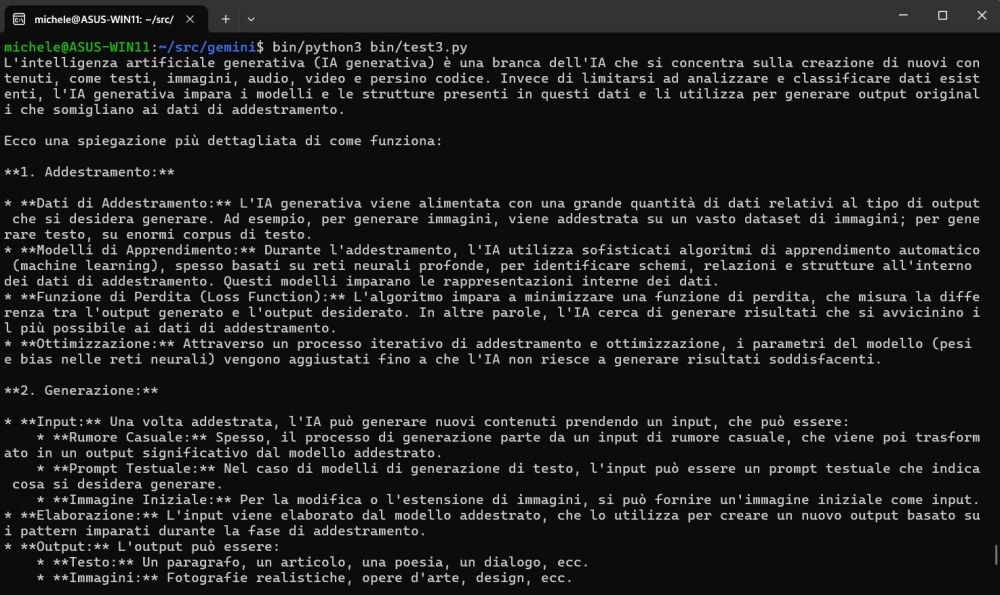

Un esempio di codice per dialogare con Gemini 2.0 via API

A questo punto, si può digitare il comando nano bin/test.py per creare un nuovo script Python.

Incollando quanto segue, è possibile dialogare con Gemini 2.0 tramite API:

from google import genai

client = genai.Client(

api_key="CHIAVE_API"

)

response = client.models.generate_content(

model="gemini-2.0-flash-exp", contents="Spiega come funziona l'intelligenza artificiale generativa"

)

print(response.text)

La stringa CHIAVE_API deve ovviamente essere sostituita con l’API key generata in precedenza. Premendo CTRL+O quindi CTRL+X, è possibile salvare lo script Python, per poi eseguirlo con il seguente comando:

bin/python3 bin/test.py

Utilizzare le funzionalità di Grounding

Usando come base gli esempi di codice presentati da Google in questo documento di supporto, si può fare in modo che l’AI generi su richiesta dei “contenuti freschi” basandosi sui dati di attualità e, quindi, servendosi delle informazioni pubblicamente disponibili sul Web:

from datetime import date

from google import genai

from google.genai.types import Tool, GoogleSearch, GenerateContentConfig

client = genai.Client(api_key="CHIAVE_API")

google_search_tool = Tool( google_search = GoogleSearch() )

oggi = date.today()

dataodierna = oggi.strftime("%d %B %Y")

response = client.models.generate_content(

model="gemini-2.0-flash-exp",

contents="Trova le ultime novità relative al mercato azionario in Europa per oggi " + dataodierna,

config=GenerateContentConfig(

tools=[google_search_tool],

response_modalities=["TEXT"]

)

)

for each in response.candidates[0].content.parts:

print(each.text)

Conclusioni

Gemini 2.0 rappresenta un punto di svolta nel panorama dell’intelligenza artificiale, offrendo una combinazione unica di capacità multimodali, prestazioni avanzate e accessibilità gratuita attraverso le API di Google. Grazie alla sua architettura, il modello non solo risponde alle esigenze di sviluppatori e aziende, ma apre nuove possibilità per migliorare l’esperienza utente in una vasta gamma di applicazioni.

La versione Flash di Gemini 2.0 enfatizza ulteriormente questi aspetti, garantendo una maggiore velocità e prestazioni senza compromessi sulla qualità delle risposte, rendendolo ideale per soluzioni che richiedono interazioni rapide e fluide.

L’approccio innovativo del modello, unito alla funzionalità di Grounding, dimostra come l’AI possa superare i limiti tradizionali dei modelli linguistici, integrando informazioni aggiornate in tempo reale e migliorando l’accuratezza delle risposte.

Credit immagine in apertura: Google

/https://www.ilsoftware.it/app/uploads/2024/12/gemini-20-api-python.jpg)

/https://www.ilsoftware.it/app/uploads/2025/04/comandi-ai-tag-gestire-schede-browser.jpg)

/https://www.ilsoftware.it/app/uploads/2024/12/3-11.jpg)

/https://www.ilsoftware.it/app/uploads/2025/04/whatsapp-automazione-claude-AI.jpg)

/https://www.ilsoftware.it/app/uploads/2025/04/vulnerabilita-bootloader-AI.jpg)