/https://www.ilsoftware.it/app/uploads/2023/12/WALT-genera-video-da-descrizioni-testuali.jpg)

Non sono passati che pochi giorni dalla presentazione del modello Gemini di ultima generazione che Google sembra voler squassare il mercato con un’ulteriore novità. Certo, ancora si parla di uno studio elaborato da un gruppo di ricercatori dell’azienda di Mountain View con la collaborazione di un team di studiosi delle università di Stanford e del Georgia Institute of Technology. Tuttavia, Google dimostra di essere già in possesso di una tecnologia per creare video da una descrizione testuale.

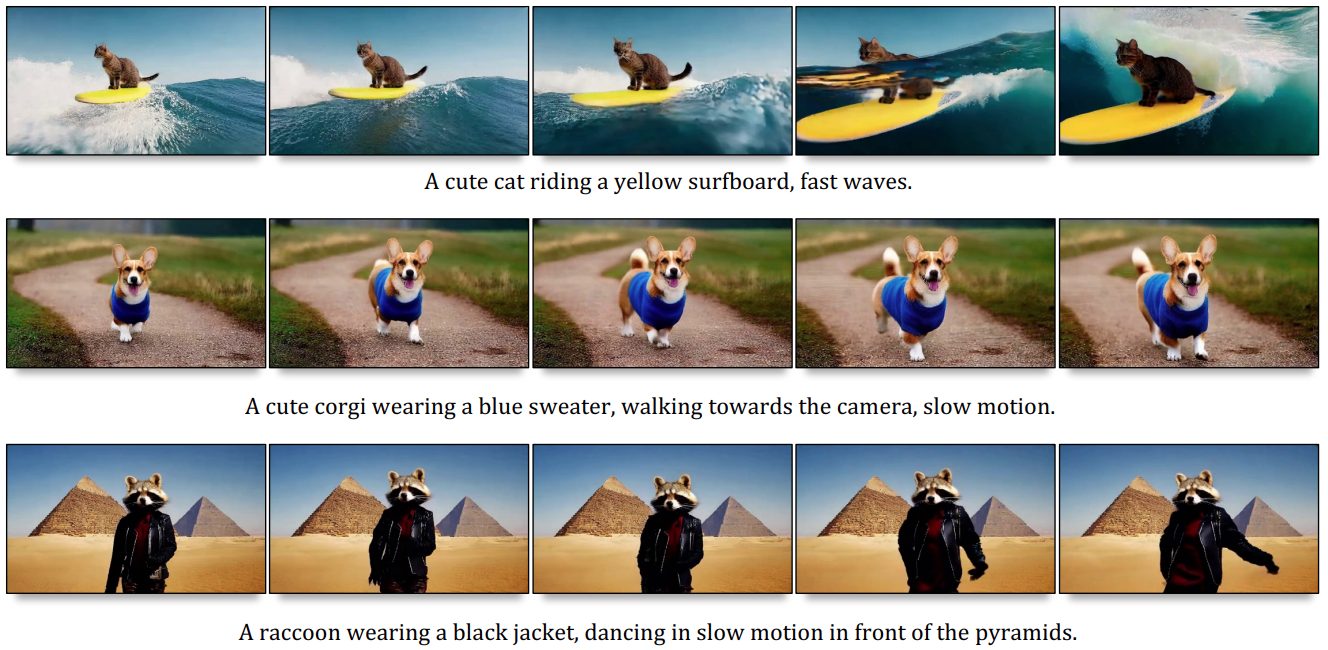

I risultati lasciano di stucco: guardate gli esempi pubblicati in questa pagina. Come si può vedere, la pagina propone tanti esempi di video: spostando il puntatore del mouse su ciascuno di essi, è possibile leggere la richiesta in linguaggio naturale che ha portato alla generazione del file. Premendo il tasto F5 o comunque ricaricando la stessa pagina, sono proposti tanti altri esempi.

W.A.L.T. è il nuovo sistema che crea video da una descrizione testuale: Google è in prima linea

Dietro alla “magia” c’è W.A.L.T. (Window Attention Latent Transformer), un innovativo sistema per la generazione di video fotorealistici basato sull’utilizzo dei transformer e di un meccanismo di modellazione per diffusione.

La modellazione della diffusione è una tecnica che può essere utilizzata per generare immagini o video campionando iterativamente da una distribuzione di probabilità. La diffusione può essere vista come il processo di generazione di pixel o elementi di un’immagine o di un video.

La procedura coinvolge una serie di passaggi ripetuti (approccio iterativo): ad ogni iterazione, nuovi pixel o elementi vengono aggiunti o modificati, contribuendo alla progressiva formazione dell’immagine o del video finali. La citata distribuzione di probabilità guida il processo di campionamento, determinando quali valori sono più probabili o meno probabili ai fini dell’eventuale selezione. Un campionamento così effettuato consente di introdurre casualità e variazioni, contribuendo a rendere il contenuto generato più realistico e interessante.

Secondo i ricercatori Google e gli altri collaboratori che hanno partecipato al progetto, W.A.L.T. garantisce prestazioni di primo livello con vari benchmark legati alla generazione di video (UCF-101 e Kinetics-600) e immagini (ImageNet).

L’addestramento di ben tre modelli in cascata per la generazione di video a partire dal testo consente l’ottenimento di risultati entusiasmanti. Si parte da un “Base Latent Video Diffusion” che fa leva su “informazioni latenti” ovvero caratteristiche fondamentali e aspetti chiave del video da generare.

Il sistema utilizza in sequenza due modelli “Video Super-Resolution Diffusion“, appositamente progettati per effettuare l’upscaling delle immagini del video e migliorare la risoluzione della sequenza prodotta. In questo caso fino a 512 x 896 pixel. I tre modelli adoperati in cascata abilitano la cosiddetta “text-to-video generation” traducendo i testi in sequenze di video a una velocità di 8 fotogrammi al secondo.

/https://www.ilsoftware.it/app/uploads/2023/12/intelligenza-artificiale-browser-mozilla.jpg)

/https://www.ilsoftware.it/app/uploads/2025/04/SoC-intel-automotive.jpg)

/https://www.ilsoftware.it/app/uploads/2023/07/Adobe-Firefly-logo-IA-generativa-immagini-min.jpg)

/https://www.ilsoftware.it/app/uploads/2025/04/rayban-meta-occhiali-smart.jpg)