Un certo numero di artisti, produttori di contenuti e persino etichette discografiche hanno intentato azioni legali contro le società che sviluppano modelli generativi basati sull’intelligenza artificiale. Tanto che adesso si è arrivati al punto di avvelenare le intelligenze artificiali in maniera tale che non possano utilizzare contenuti protetti dalle norme a tutela della proprietà intellettuale.

I modelli generativi hanno ha la capacità di generare dati, spesso in forma di testo, immagini o suoni, che sembrano prodotti da esseri umani. Essi sfruttano reti neurali artificiali profonde per “imparare” da un insieme di dati di addestramento e generare, in un secondo tempo, dati simili a quelli presenti nei dati di addestramento stessi. Durante la fase di addestramento, il modello impara a rilevare le relazioni, le strutture e i pattern nei dati.

ChatGPT esiste ormai da novembre 2022 e il suo successo senza confini ha reso evidenti le potenzialità dei modelli generativi basati sull’idea dei Transformer. Quell’idea fu presentata nel 2017 da un gruppo di ingegneri Google ma sulla sua effettiva implementazione, l’azienda di Mountain View si è fatta cogliere di sorpresa.

I modelli generativi e il tema del copyright

Per OpenAI il problema copyright nel caso dei modelli generativi non esiste: la tesi portata avanti dai legali della società di Sam Altman è che i contenuti prodotti da ChatGPT, così come dagli altri modelli generativi basati su GPT (Generative Pre-trained Transformer), non sono generati a partire da un database contenente informazioni protette dal diritto d’autore ma dalla “conoscenza” sviluppata da parte dell’intelligenza artificiale (a partire anche da contenuti protetti da copyright). In altre parole, la fase di addestramento di un modello generativo è utile a sviluppare le “competenze” necessarie per sviluppare nuovi contenuti, testi, immagini o suoni che siano. Esattamente come farebbe una persona in carne ed ossa leggendo i testi pubblicati sul Web. I lavori prodotti da “GPT e soci” sarebbero insomma “ampiamente trasformativi” e ispirati ai principi del “fair use“.

Presentato Nightshade, meccanismo per avvelenare le intelligenze artificiali

L’addestramento dei modelli generativi è il carburante che permette il funzionamento di ogni intelligenza artificiale. Sviluppato dai ricercatori dell’Università di Chicago, Nightshade è uno strumento open source che permette di modificare le immagini prima di pubblicarle sulla rete Internet così da proteggere il proprio lavoro nei confronti dell’uso non autorizzato da parte delle intelligenze artificiali.

Il meccanismo si basa sull’alterazione dei pixel che compongono l’immagine in modo impercettibile all’occhio umano. Un essere umano che guarda l’immagine non noterà alcuna differenza tra l’originale e la versione “avvelenata”. Tuttavia, i modelli che useranno quell’immagine durante la fase di addestramento “sporcheranno” irrimediabilmente le informazioni raccolte.

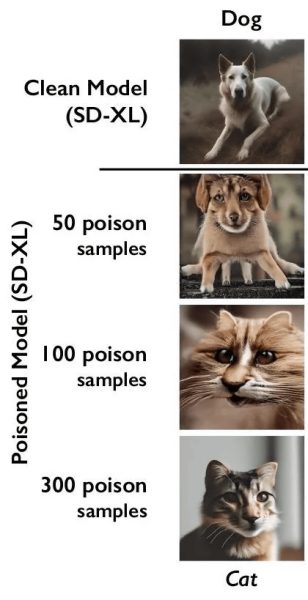

Nightshade induce in errore le intelligenze artificiali riguardo ai nomi degli oggetti raffigurati nelle foto e agli scenari rappresentati. Ad esempio, è possibile “avvelenare” le immagini dei cani in modo che, agli occhi di un modello di IA, sembrino gatti. Dopo aver addestrato il modello AI su un certo numero di queste immagini “avvelenate”, il modello comincerà a generare immagini di cani con aspetti insoliti e lontani dalla realtà.

È difficile riconoscere se le immagini sono avvelenate

La tecnica di avvelenamento dei dati utilizzata da Nightshade, presentata in questo documento, è difficile da riconoscere: gli sviluppatori dei modelli generativi dovrebbero individuare e rimuovere le immagini contenenti pixel modificati ad arte. Dal momento che essi sono introdotti in maniera che risultino irriconoscibili dall’occhio umano, anche gli strumenti software per l’estrazione dei dati possono trovarsi in seria difficoltà. Qualsiasi immagine “avvelenata” già inclusa in un set di dati di addestramento dovrebbe essere individuata e rimossa. Se un modello fosse già addestrato su tali immagini, è probabile che debba essere nuovamente sottoposto a un’ulteriore fase di addestramento. Con tutte le conseguenze del caso.

L’immagine sopra mostra un esempio di utilizzo di addestramento del modello Stable Diffusion XL con le immagini modificate da Nightshade. La versione “pulita” del modello produce l’immagine di un cane quando l’utente ne richiede la generazione. Avvelenando il modello con 50 immagini provenienti da Nightshade, l’immagine del cane comincerà ad essere instabile. Passando al modello 100-300 immagini modificate da Nightshade, Stable Diffusion XL visualizzerà l’immagine di un gatto anche quando gli viene chiesto di produrre la foto di un cane.

È iniziato il braccio di ferro tra i detentori dei diritti sui contenuti e i promotori di intelligenze artificiali sempre più abili e complesse.

Credit immagine in apertura: iStock.com/Just_Super

/https://www.ilsoftware.it/app/uploads/2023/10/avvelenare-IA-cosa-significa.jpg)

/https://www.ilsoftware.it/app/uploads/2024/09/1-8.jpg)

/https://www.ilsoftware.it/app/uploads/2024/12/3-11.jpg)

/https://www.ilsoftware.it/app/uploads/2025/04/flux_image_475925_1745315889.jpeg)

/https://www.ilsoftware.it/app/uploads/2024/12/2-3.jpg)