/https://www.ilsoftware.it/app/uploads/2023/05/img_15330.jpg)

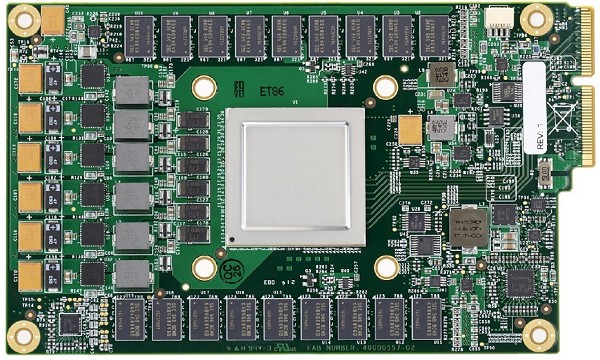

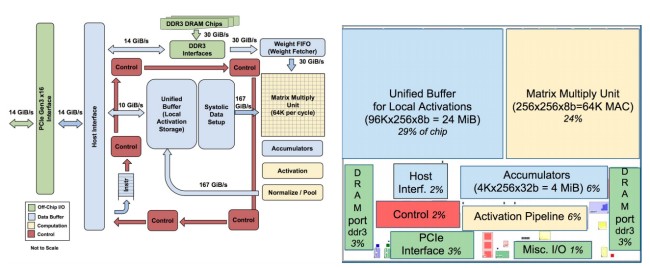

Poco meno di un anno fa Google presentò un innovativo chip (TPU, Tensor Processing Unit) progettato per il calcolo dei tensori, un’entità algebrica poco conosciuta. La nozione di tensore generalizza infatti tutte le strutture definite usualmente in algebra lineare a partire da un singolo spazio vettoriale.

Già all’epoca dedicammo un intero articolo al nuovo chip TPU di Google (Google spinge sul machine learning con il chip TPU) e alle sue molteplici applicazioni nel campo dell’intelligenza artificiale (Intelligenza artificiale, cos’è e qual è la differenza con il machine learning).

I ricercatori di Google hanno però deciso oggi di rivelare maggiori dettagli sul funzionamento del chip TPU pubblicando un interessantissimo documento accademico che ne analizza anche gli aspetti più ostici.

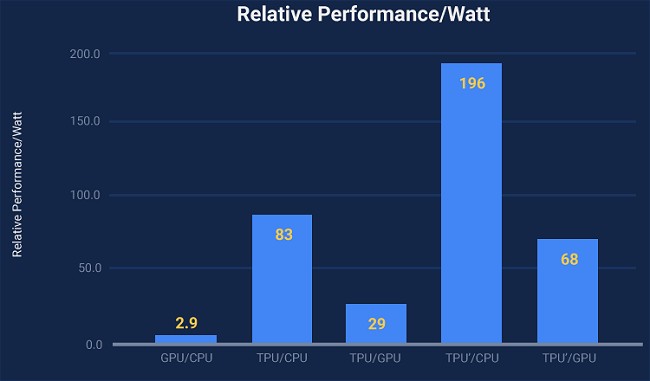

Secondo Google un chip TPU è in grado di effettuare le elaborazioni utili per le attività di machine learning da 15 a 30 volte più velocemente rispetto a un processore Intel o a una GPU NVidia.

I consumi energetici dei chip TPU, poi, è molto contenuto tanto che si calcola che abbiano prestazioni per watt dal 30% all’80% migliori.

Si tratta infatti di circuiti integrati creato appositamente per risolvere un’applicazione di calcolo ben precisa (ASIC, application specific integrated circuit).

Ecco perché nel descrivere le mirabolanti prestazioni dei suoi chip TPU, i tecnici di Google parlano comunque di inferenza ovvero dell’utilizzo, in ambito machine learning, di un modello già frutto di una precedente fase di addestramento (la procedura di training della macchina ha caratteristiche molto diverse…).

Le reti neurali che sovrintendono le applicazioni sviluppate da Google richiedono, grazie ai chip TPU e all’impiego del framework TensorFlow (Google punta sul machine learning: ecco la piattaforma cloud), un numero davvero esiguo di righe di codice (dalle 100 alle 1.500).

/https://www.ilsoftware.it/app/uploads/2024/09/ragionamento-intelligenza-artificiale-open-source.jpg)

/https://www.ilsoftware.it/app/uploads/2025/03/openai-operator-chatgpt.jpg)

/https://www.ilsoftware.it/app/uploads/2024/01/intelligenza-artificiale-applicazioni-ollama-librerie.jpg)

/https://www.ilsoftware.it/app/uploads/2025/03/ILSOFTWARE-6-1.jpg)