Come avevamo sottolineato nei giorni scorsi, l’arrivo di DeepSeek è stata cosa buona. Si è trasformato in uno sprone per OpenAI e le altre realtà occidentali impegnate nell’offrire soluzioni di intelligenza artificiale (AI). Nemmeno durante la scorsa stagione natalizia OpenAI si è rivelata così feconda in termini di novità. Con il tentativo di fuga di DeepSeek registrato nei giorni scorsi, si sta evidenziando il lancio di molteplici innovazioni in ambito AI. E quando la competizione cresce, a trarne beneficio sono gli utenti finali.

Uno dei più importanti elementi innovativi introdotti nei Large Language Models (LLM) nell’ultimo periodo, consiste nell’utilizzo della cosiddetta catena di pensiero, catena di ragionamento o chain-of-thought (CoT).

Cos’è la catena di pensiero o di ragionamento nei modelli AI

Abbiamo più volte raccontato come, per la loro stessa natura, i LLM usati nelle applicazioni di intelligenza artificiale vadano in grave difficoltà quando devono essere gestiti compiti logico-matematici. In passato abbiamo dimostrato come ChatGPT commettesse errori madornali in questo campo.

I comportamenti anomali con i problemi di logica e matematica derivano in parte dal fatto che i LLM si affidano ai dati acquisiti in fase di addestramento (non hanno mai “visto” prima problemi nuovi che l’utente può porre sotto forma di prompt), in parte dalla tokenizzazione. I modelli, cioè, evidenziano deficit cognitivi che portano a fallimenti in operazioni aritmetiche banali come confrontare numeri decimali (ad esempio 9,11 con 9,9). Come abbiamo visto nell’articolo sulle 10 cose tecniche da sapere su ChatGPT, questo comportamento deriva principalmente dall’uso di rappresentazioni numeriche basate su token anziché su calcoli matematici diretti.

A distanza di neppure un anno, le cose sono radicalmente cambiate e sia ChatGPT come altri chatbot basati su modelli evoluti riescono a superare brillantemente quesiti complessi, arrivando alla soluzione dopo diversi passaggi di “ragionamento”. In un altro articolo abbiamo spiegato come far ragionare le intelligenze artificiali e ottenere risposte corrette.

Il termine “ragionamento” nel contesto dei modelli AI potrebbe sembrare fuori luogo se si considera che il ragionamento umano è un processo complesso e intuitivo. Tuttavia, nell’ambito dell’intelligenza artificiale e in particolare dei LLM, il ragionamento si riferisce alla capacità dei sistemi di elaborare informazioni, trarre conclusioni logiche e prendere decisioni basate sui dati disponibili. Con un processo che imita i meccanismi cognitivi umani ma opera attraverso algoritmi e approcci matematici.

Un esempio di catena di pensiero o di riflessione

La chain-of-thought (CoT) è una tecnica utilizzata nei LLM per migliorare significativamente le loro capacità di ragionamento. La chiave di volta consiste nello scomporre compiti complessi in una serie logica e coerente di passaggi intermedi che portano alla soluzione finale.

La catena di pensiero nei modelli AI funziona addestrando i LLM a generare catene di pensieri analoghe a quelle umane. Ad esempio, se si chiede ai nuovi modelli di tipo reasoning/thinking di risolvere un problema matematico del tipo “Un oggetto costa inizialmente 100 €. Nel primo mese il prezzo aumenta del 20% e nel mese successivo viene diminuito del 20%. Qual è il prezzo finale dell’oggetto?“, una volta il sistema sarebbe andato in crisi.

Oggi, invece, si ottiene la seguente catena logica che porta alla soluzione corretta:

Catena Logica (Chain-of-Thought):

- Calcolo dell’aumento del 20%:

- Partiamo dal prezzo iniziale di 100 €.

- Un aumento del 20% significa aggiungere il 20% di 100 €, cioè:

100×0,20=20€- Quindi, il nuovo prezzo dopo l’aumento è:

100+20=120€- Calcolo della diminuzione del 20% sul nuovo prezzo:

- Ora, a partire dai 120 €, applichiamo una diminuzione del 20%.

- Il 20% di 120 € è:

120×0,20=24€- Riducendo 120 € di 24 €, il prezzo diventa:

120−24=96 €.- Conclusione:

- Il prezzo finale dell’oggetto, dopo l’aumento e la successiva diminuzione, è 96 €.

Ovviamente, quello presentato è volutamente un esempio banale ma lo stesso schema è utilizzato per gestire qualunque problema, anche i più complessi. Anche quelli a livello accademico e di dottorato di ricerca.

OpenAI e la nuova evoluzione del ragionamento nei modelli AI

OpenAI ha annunciato un nuovo importante aggiornamento riguarda del suo modello o3-mini, che ora offre una maggiore trasparenza nel suo processo di ragionamento, migliorandone la comprensione da parte degli utenti.

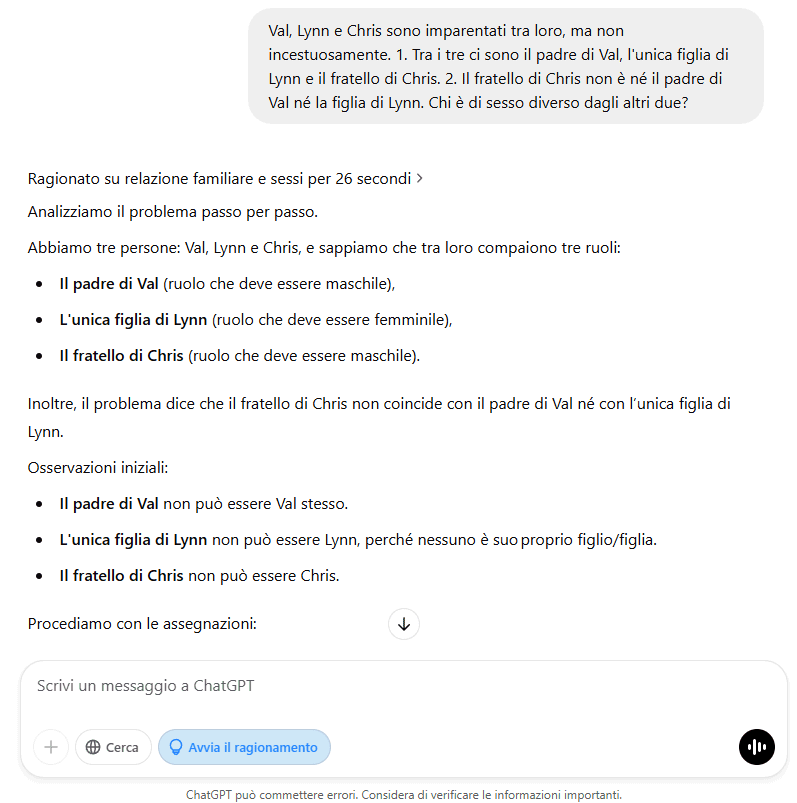

Il modo più rapido per provare i benefici del nuovo modello o3-mini consiste nel ricorrere a ChatGPT e cliccare sul pulsante Avvia il ragionamento.

L’azienda guidata da Sam Altman fa notare che le nuove abilità in termini di catena di pensiero che contraddistinguono o3-mini sono fruibili da tutti gli utenti, compresi quelli che usando ChatGPT Free, ovvero la versione gratuita del chatbot. Con un clic su Avvia il ragionamento, ponendo un quesito logico-matematico, è finalmente possibile visualizzare con maggiore chiarezza i passaggi logici utilizzati dal modello per giungere alle risposte.

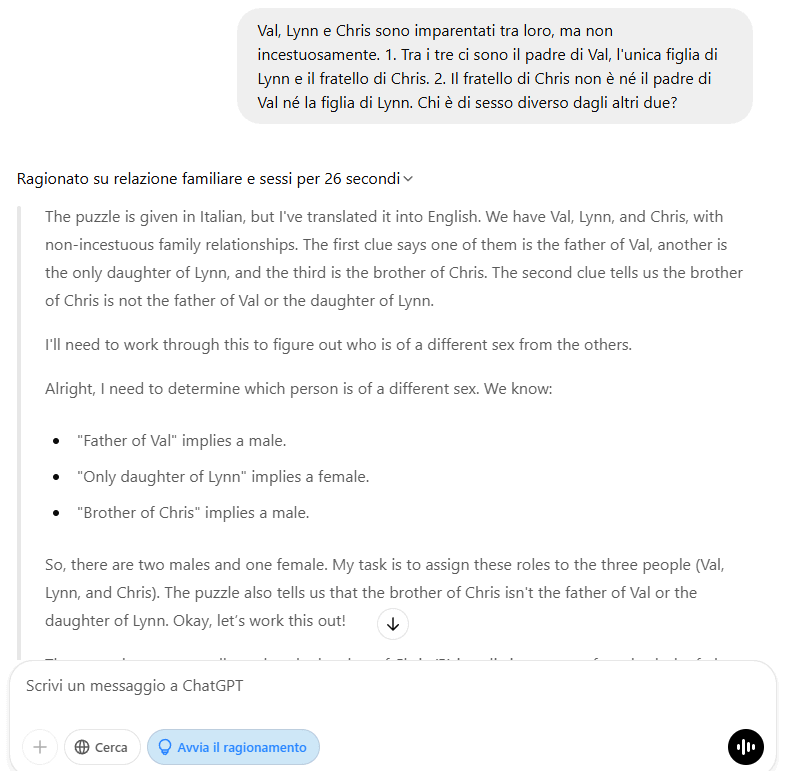

Dopo aver inviato il prompt a ChatGPT, con un clic sulla freccia in alto (nel punto in cui figura la frase Ragionato su … per N secondi), si può accedere alla lista completa dei passaggi di ragionamento che l’AI ha svolto prima di giungere alla risposta definitiva.

Come vedete, il quesito in italiano è automaticamente tradotto dal modello sul quale si basa ChatGPT e ciascun passaggio è poi svolto in inglese per poi produrre l’output finale nella nostra lingua.

Secondo un portavoce di OpenAI, l’obiettivo è rendere più chiaro il funzionamento del modello, aumentando la fiducia nelle sue risposte.

Ragionamento e verifica: un bilanciamento complesso

I modelli basati sul ragionamento, come o3-mini, sono progettati per controllare accuratamente le proprie affermazioni prima di fornire una risposta. L’obiettivo è quello di ridurre il rischio di errori, diversamente molto comuni nei modelli AI. Lo scotto, ovviamente, si paga con un leggero aumento del tempo di elaborazione delle risposte.

Fino a poco tempo fa, OpenAI aveva scelto di non mostrare completamente i passaggi di ragionamento svolti dai suoi modelli, inclusi o1 e o1-mini. Gli utenti potevano vedere solo sintesi del processo logico, che talvolta contenevano inesattezze.

Per migliorare chiarezza e sicurezza, OpenAI ha introdotto un ulteriore passaggio di post-elaborazione. È un po’ l’approccio presentato di recente dagli accademici di Stanford e Washington con il loro modello s1 da 50 dollari. In questa fase, il modello OpenAI rivede la catena di pensiero grezza, elimina eventuali contenuti inappropriati e semplifica eventuali concetti complessi. Inoltre, il processo consente agli utenti non anglofoni di ricevere il ragionamento nella loro lingua madre, rendendo l’interazione più accessibile e intuitiva.

Nel frattempo DeepSeek sta ancora pensando…

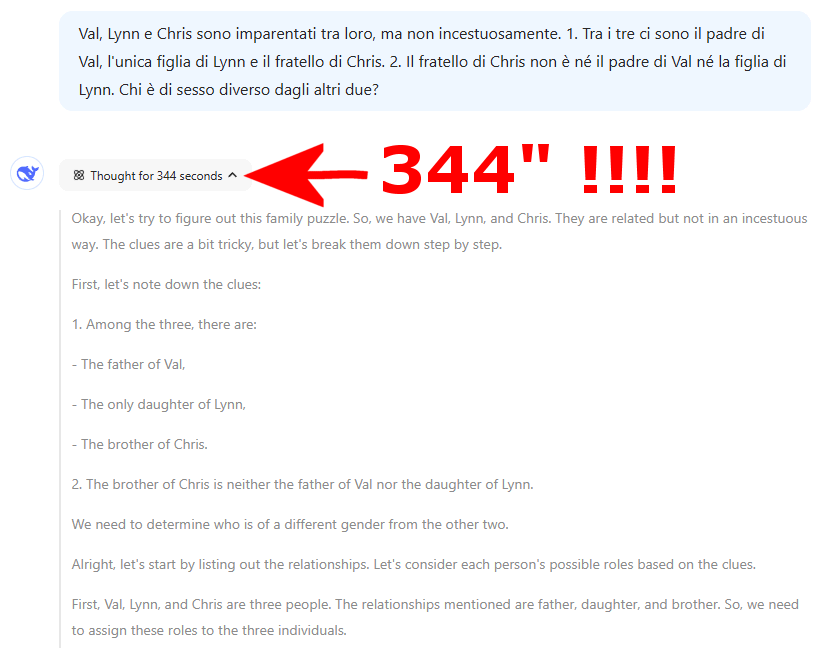

Il seguente quiz, tratto dal libro Test Your Logic, disponibile su Google Books, non ha messo in difficoltà o3-mini su ChatGPT, che ha fornito la risposta corretta dopo appena 26 secondi:

Val, Lynn e Chris sono imparentati tra loro, ma non incestuosamente. 1. Tra i tre ci sono il padre di Val, l’unica figlia di Lynn e il fratello di Chris. 2. Il fratello di Chris non è né il padre di Val né la figlia di Lynn. Chi è di sesso diverso dagli altri due?

Nei giorni scorsi, DeepSeek-R1 aveva fornito una risposta convincente ma riprovando oggi il modello, dopo oltre 5 minuti di ragionamento, era ancora “incartato” nel risolvere l’enigma. Che, diversamente rispetto a quanto possa apparire a una prima lettura, risulta abbastanza semplice. Alla fine, la risposta giusta è comunque arrivata (in inglese).

Credit immagine in apertura: iStock.com – BlackJack3D

/https://www.ilsoftware.it/app/uploads/2025/02/catena-di-pensiero-ragionamento-modelli-AI.jpg)

/https://www.ilsoftware.it/app/uploads/2023/06/OpenAI-Logo-GPT-ChatGPT-IA-min.jpg)

/https://www.ilsoftware.it/app/uploads/2025/04/flux_image_475760_1744976324.jpeg)

/https://www.ilsoftware.it/app/uploads/2024/07/chip-IA-openai.jpg)

/https://www.ilsoftware.it/app/uploads/2025/04/grok-lg-ai-emotiva-pubblicita.jpg)