I modelli generativi più avanzati per la creazione di immagini con l’intelligenza artificiale, come il noto Stable Diffusion, potrebbero presto doversi misurare con un “peso massimo” nella loro stessa categoria. L’ultima versione di PixArt, frutto del lavoro di un team di ricercatori Huawei Noah’s Ark Lab, dei poli accademici della Dalian University of Technology e della Tsinghua University, oltre che di Hugging Face, si presenta in grado di introdurre significativi benefici in termini prestazionali.

PixArt-δ: genera immagini di qualità con l’intelligenza artificiale in appena mezzo secondo

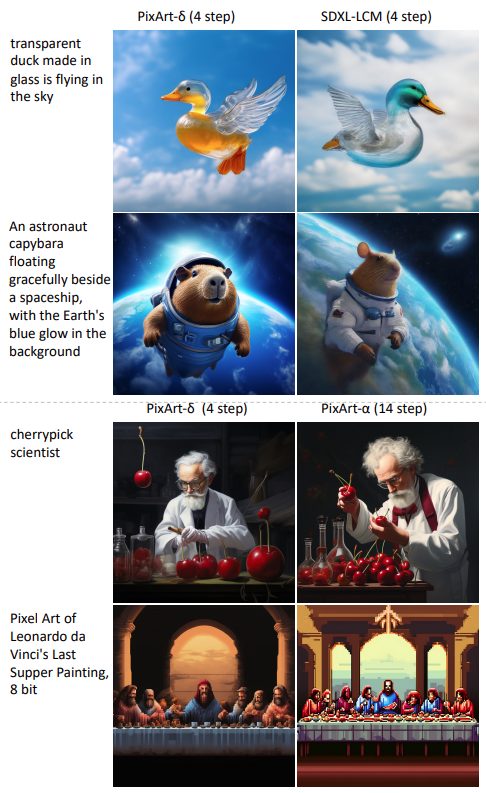

PixArt-δ (Delta) è un framework avanzato di sintesi testo-immagine progettato appunto per competere con la famiglia Stable Diffusion. La principale novità rispetto ai modelli di precedente generazione, è che PixArt-δ è capace di generare immagini ad alta risoluzione (1024 x 1024 pixel) in appena mezzo secondo, utilizzando soli due o quattro passaggi. Si tratta di prestazioni velocistiche che risultano sette volte migliori rispetto a PixArt-α.

SDXL Turbo, presentato da Stability AI a novembre 2023, può generare immagini di dimensioni pari a 512 x 512 pixel in un solo passaggio (circa 0,2 secondi). Tuttavia, i risultati di PixArt-δ assicurano l’ottenimento di risoluzioni maggiori e appaiono più in linea con il prompt fornito, contenendo in generale anche meno errori.

Come si apprende leggendo lo studio incentrato su PixArt-δ, il nuovo modello può essere addestrato in modo efficiente su GPU NVidia V100 con 32 GB di VRAM in meno di un giorno di lavoro. Inoltre, la sua capacità di inferenza a 8 bit consente di sintetizzare immagini da 1024 pixel anche su GPU da 8 GB, migliorando notevolmente la sua usabilità e accessibilità.

Controllo puntuale del processo di generazione delle immagini

Il modello PixArt-δ appena svelato, integra anche un modulo ControlNet per il controllo più preciso della procedura di diffusione testo-immagine utilizzando immagini di riferimento. I ricercatori, in particolare, hanno reso pubblici i parametri (o pesi) associati alla variante ControlNet del modello PixArt-δ sulla piattaforma Hugging Face.

Nei contesti di apprendimento automatico e deep learning, i “pesi” si riferiscono ai parametri interni di un modello che vengono addestrati durante il processo di apprendimento. Essi influenzano la capacità del modello di fare previsioni o generare output. La condivisione dei pesi permette di ottimizzare e adattare il modello per le proprie applicazioni e gli esperimenti che si desiderano svolgere.

Al momento in cui scriviamo, la demo del modello PixArt-δ non risulta ancora accessibile pubblicamente. È invece verificabile il funzionamento di PixArt-α nella versione LCM (Latent Consistency Model) e ControlNet.

Nell’apprendimento automatico, il “latent space” si riferisce a uno spazio astratto in cui i dati sono rappresentati in una forma più compatta e significativa: LCM lavora all’interno di questo spazio. Inoltre, usa il meccanismo di “diffusione” per generare l’immagine in maniera graduale attraverso una serie di passaggi.

/https://www.ilsoftware.it/app/uploads/2024/01/pixart-generazione-immagini-IA.jpg)

/https://www.ilsoftware.it/app/uploads/2025/04/comandi-ai-tag-gestire-schede-browser.jpg)

/https://www.ilsoftware.it/app/uploads/2024/12/3-11.jpg)

/https://www.ilsoftware.it/app/uploads/2025/04/whatsapp-automazione-claude-AI.jpg)

/https://www.ilsoftware.it/app/uploads/2025/04/vulnerabilita-bootloader-AI.jpg)