L’annuncio è di quelli che sembrano davvero iperbolici. La prima reazione di fronte all’affermazione di qualcuno che sostiene di essere in grado di moltiplicare di 100 volte le prestazioni delle attuali CPU non può che essere critica. Un balzo in avanti del genere va ben oltre le più rosee aspettative quando, ad esempio, un produttore di chip presenta una nuova generazione delle sue architetture per microprocessori.

Eppure, la piccola startup finlandese Flow Computing esce dall’anonimato e fa una “dichiarazione bomba”. Dopo aver ricevuto un primo finanziamento da 4 milioni di euro, i fondatori della società svelano il concetto di PPU (Parallel Processing Unit), un’architettura che permetterebbe di assicurare fino a 100 volte le prestazioni di qualsiasi CPU di oggi.

Secondo Timo Valtonen, co-fondatore e CEO di Flow Computing, ci troviamo alle porte dell’era “CPU 2.0“: si tratta di un ripensamento radicale delle strutture di base che governano il funzionamento dei processori. Un modo diverso di guardare le cose che permette di introdurre miglioramenti davvero tangibili sul piano delle prestazioni.

È vero che si possono migliorare di 100 volte le prestazioni delle attuali CPU?

L’idea di PPU nasce dalla precisa volontà di superare la stagnazione in fatto di performance che ha complessivamente contraddistinto il mercato delle CPU nel corso degli ultimi anni. La CPU, da vero “campione velocistico”, si è trasformata in una sorta di collo di bottiglia capace di affossare – in alcuni casi – le performance dei moderni sistemi informatici.

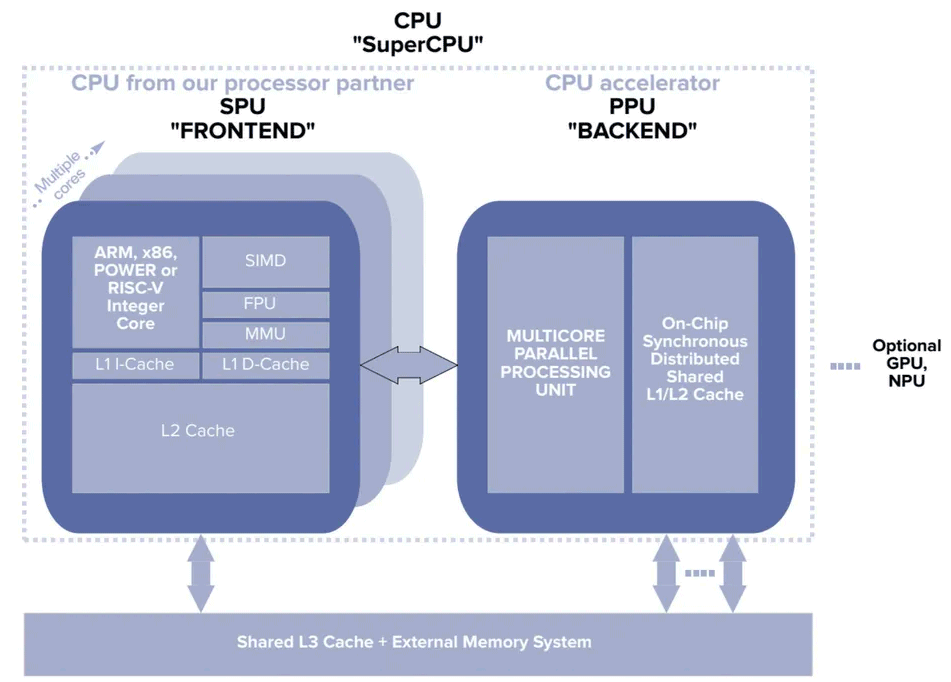

Flow Computing non ha ancora svelato i dettagli tecnici del funzionamento di PPU. Limitandoci alle informazioni “ad alto livello” fornite dall’azienda scandinava, si capisce che l’obiettivo è quello di affiancare alle CPU odierne un modulo PPU. Secondo gli ingegneri della startup, qualsiasi CPU basata sull’architettura di Von Neumann può integrare una PPU, con licenze già pronte per processori mobili, desktop e data center.

Indipendentemente dall’architettura CPU sottostante, Flow Computing precisa che le sue PPU sono compatibili con qualunque chip: ad esempio x86, RISC-V e ARM. Inoltre, le PPU – che possono avere da 4 a 256 core in parallelo – sono integrabili con i processori di qualsivoglia produttore.

Secondo i portavoce di Flow Computing, inoltre, le PPU eliminano la necessità di gestire costose elaborazioni accelerate attraverso la GPU, con particolare riguardo per le applicazioni ad alte prestazioni. Eventuali coprocessori esistenti, come unità matriciali, unità vettoriali, NPU o addirittura GPU, trarrebbero a loro volta beneficio dalla presenza di una CPU “molto più capace”.

Ogni PPU, inoltre, sarebbe in grado di adattare dinamicamente il numero di core impiegati in parallelo, in base ai carichi di lavoro istantanei.

I pilastri per il miglioramento delle prestazioni delle CPU

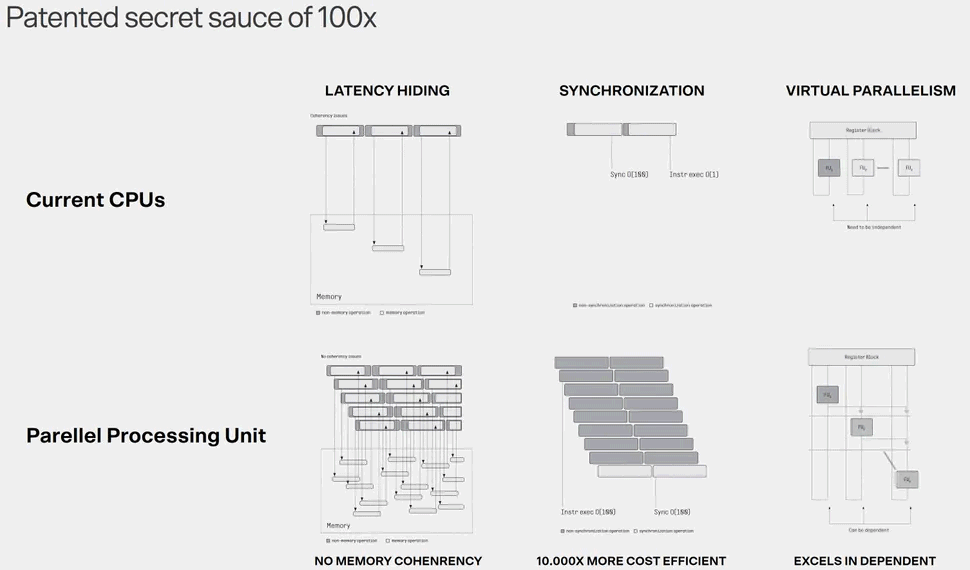

Per guardare alle CPU 2.0, Flow Computing presenta alcuni pilastri che costituiscono le fondamenta dei moduli PPU.

Si parla innanzi tutto di Latency Hiding. Attualmente, l’accesso alla memoria rappresenta una grossa sfida per le CPU multi-core a causa della latenza dell’interconnessione e dei problemi di coerenza della cache. L’unità PPU risolve questo collo di bottiglia avvantaggiandosi con l’esecuzione parallela di ulteriori thread mentre si verifica l’accesso alla memoria. Non ci sono problemi di coerenza poiché non ci sono cache di fronte al sistema di interconnessione. La scalabilità è fornita da una rete on-chip ad elevata larghezza di banda.

Nelle attuali CPU multi-core, l’utilizzo del parallelismo richiede costose operazioni di sincronizzazione tra thread (da 100 a 1000 cicli di clock) quando ci sono dipendenze. Un’attività di sincronizzazione è necessaria solo “una tantum”, diventando molto meno costosa da un punto di vista computazionale rispetto a quanto accade oggi.

Le moderne CPU, inoltre, non gestiscono in modo ottimale il parallelismo: possono eseguire istruzioni multiple solo se indipendenti. Nelle PPU, le unità funzionali sono organizzate in una catena in cui un’unità può utilizzare i risultati delle precedenti come operandi.

Inoltre, Flow Computing sta sviluppando uno strumento per aiutare gli sviluppatori di soluzioni basate sull’intelligenza artificiale a identificare le parti del codice che possono essere parallelizzate e, di conseguenza ottimizzate al fine di massimizzare le prestazioni complessive del sistema e in particolare proprio quelle della CPU.

Muoversi con i proverbiali piedi di piombo

Come prescrive il buonsenso, rivendicazioni così ambiziose come quelle di Flow Computing vanno prese con le dovute riserve. I dettagli tecnici sul funzionamento dei moduli PPU sono attesi per la seconda metà del 2024, insieme ai benchmark e ai confronti che aiuteranno a convalidare (o meno) le affermazioni dell’azienda.

Dietro a Flow Computing, comunque, ci sono soggetti di primo piano. Innanzi tutto, la startup è spin-out del rinomato VTT Technical Research Center finlandese, società senza scopo di lucro di proprietà controllata dallo Stato che è di fatto il più importante punto di riferimento per la ricerca tecnologica dell’intero Paese.

La startup, inoltre, ha raccolto un primo round di sovvenzioni da parte di un gruppo di venture capital e società del territorio scandinavo. È quindi il risultato di un mix tra ricerca accademica, capitali privati e supporto pubblico.

Un gruppo di ricercatore aveva recentemente descritto come raddoppiare le prestazioni di PC e smartphone con SHMT mentre, parlando di tecnologie già accessibili da parte di tutti (peraltro da tempo…) in un altro articolo abbiamo spiegato come migliorare le prestazioni di computer desktop e notebook aumentando la RAM.

Le immagini nell’articolo sono tratte da Flow Computing.

/https://www.ilsoftware.it/app/uploads/2024/06/aumentare-performance-CPU-100-volte-PPU-flow.jpg)

/https://www.ilsoftware.it/app/uploads/2025/04/intel-inside-2025.jpg)

/https://www.ilsoftware.it/app/uploads/2025/04/ARM-chip-cpu-data-center.jpg)

/https://www.ilsoftware.it/app/uploads/2025/04/intel-18a-produzione-chip.jpg)

/https://www.ilsoftware.it/app/uploads/2025/03/lip-bu-tan-ceo-intel.jpg)