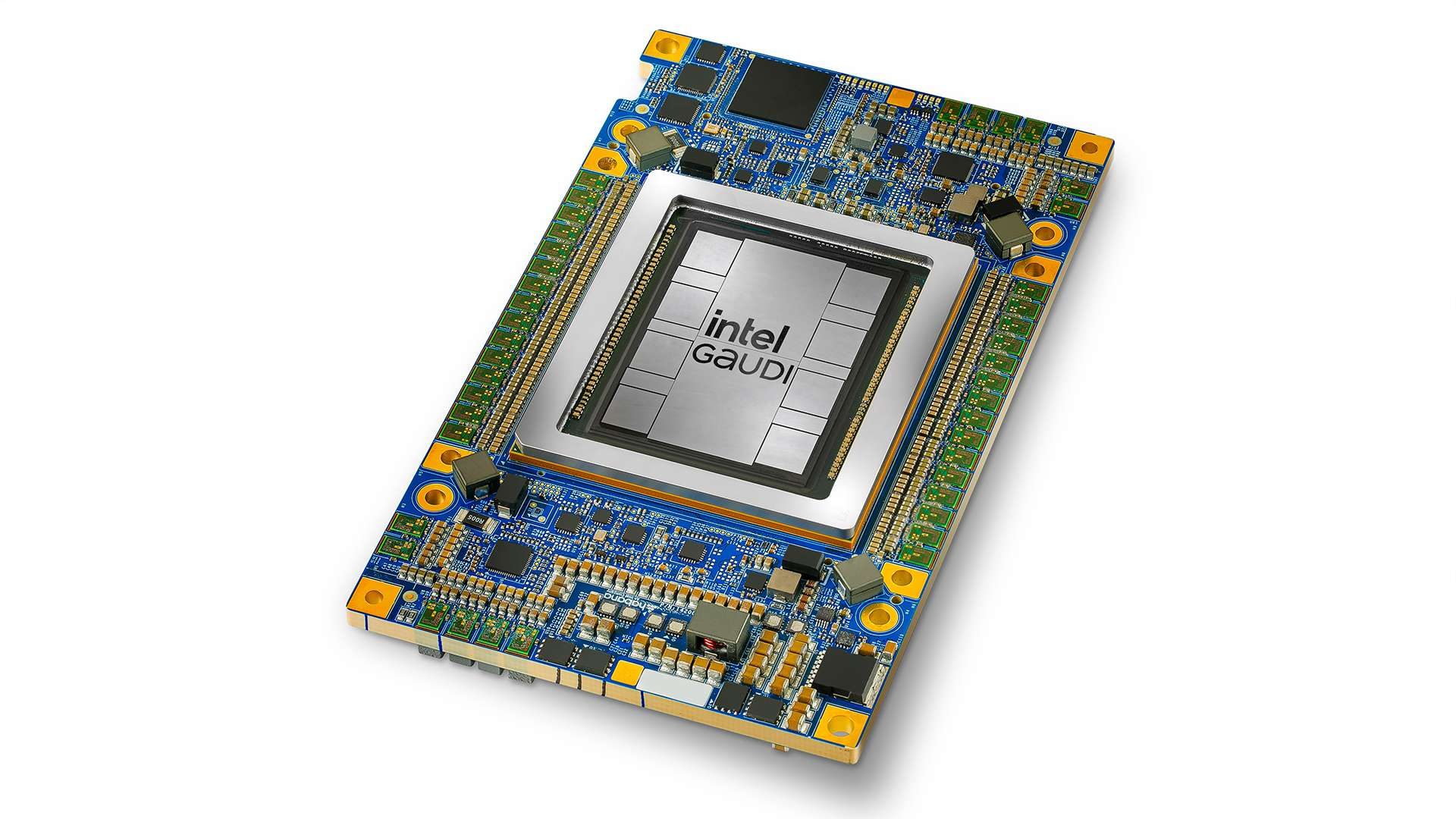

In occasione dell’evento Intel Vision 2024, la società guidata da Pat Gelsinger ha presentato l’acceleratore Gaudi 3 che porta prestazioni, standard aperti e possibilità di scelta sul versante dell’intelligenza artificiale generativa (GenAI) per le imprese.

Gaudi 3 alimenterà i sistemi di IA costituendo un passo avanti significativo nella formazione e nell’inferenza per le aziende che desiderano implementare soluzioni di intelligenza artificiale su larga scala. Intel mette in evidenza un aspetto importante: è possibile collegare migliaia di acceleratori tramite interfaccia Ethernet in modo tale da estendere e scalare a dismisura il potenziale di Gaudi 3.

Stando ai dati condivisi dai tecnici della società di Santa Clara, rispetto alle schede NVIDIA H100, Gaudi 3 dovrebbe assicurare un time-to-train mediamente più veloce del 50% con i modelli Llama2 con 7B e 13B (rispettivamente 7 e 13 miliardi di parametri) nonché sul modello con GPT-3 175B. Intel indica che il throughput nelle attività di inferenza assicurato da Gaudi 3 permetterà di superare H100 del 50% in termini di prestazioni medie e del 40% termini di efficienza energetica media, sia con Llama 7B e 70B che con Falcon 180B.

L’ecosistema si unisce per sviluppare una piattaforma aperta di Enterprise AI

In collaborazione con Anyscale, DataStax, Huggung Face, KX Systems, MariaDB, MinIO, Qdrant, Red Hat, Redis, SAP, SAS, VMware, Yellowbrick e Zilliz, Intel ha annunciato l’intenzione di creare una piattaforma aperta per l’Enterprise AI. L’iniziativa ha come obiettivo primario quello di sviluppare sistemi GenAI aperti e multi-vendor che offrano facilità di implementazione, le migliori prestazioni e valore, abilitati dell’approccio RAG (Retrieval-Augmented Generation).

RAG migliora la qualità e la coerenza del testo generato incorporando informazioni provenienti da fonti esterne. Questo approccio consente di produrre testo più informativo e accurato, in grado di rispondere in modo più preciso a una vasta gamma di domande o compiti nel contesto dell’elaborazione del linguaggio naturale.

Nel caso di Intel, il fine ultimo è quello di abilitare l’utilizzo delle estese fonti di dati proprietarie delle aziende, sfruttando soluzioni standard sicure basate su Intel Xeon con funzionalità LLM aperte, accelerando l’utilizzo della GenAI nelle imprese.

La soluzione presentata da Intel consente a un ecosistema ampio e aperto di attori nel settore dell’IA, di offrire soluzioni che soddisfano le esigenze specifiche di ciascuna azienda. Della “partita” sono produttori di apparecchiature, fornitori di database, system integrator, fornitori di software e servizi… Ogni impresa può affidarsi ai partner e alle soluzioni già note e fidate.

Il software resta punto nodale per un’offerta che vuole davvero competere nel campo dell’IA

Come ha dimostrato il dominio sin qui incontrastato di NVIDIA con CUDA, l’ecosistema software è altrettanto critico quanto l’hardware. Intel celebra “le virtù” della sua piattaforma software end-to-end e afferma che “la maggior parte” dei suoi ingegneri sta attualmente lavorando per rafforzare il supporto.

L’azienda di Gelsinger si sta attualmente concentrando sul sul supporto per modelli di addestramento e inferenza multi-modalità e RAG.

Hugging Face ha oltre 600.000 differenti versioni di modelli di IA attualmente disponibili. I portavoce di Intel affermano che la collaborazione con Hugging Face, PyTorch, DeepSpeed e Mosaic ha facilitato il processo di porting del software al fine di facilitare l’implementazione di sistemi basati su Gaudi 3.

Intel afferma che la maggior parte dei programmatori sta utilizzando framework o pacchetti software di alto livello (ad esempio semplicemente utilizzando PyTorch e scripting con Python): per la società di Santa Clara, insomma, lo sviluppo a basso livello con CUDA non sarebbe così comune come si potrebbe ritenere.

Semplificare il porting delle applicazioni per fornire un’alternativa concreta a CUDA

La complessità sottostante è gestita da Intel OneAPI, che funge da libreria kernel e di comunicazione. Il comportamento della libreria segue le specifiche delineate dalla Unified Accelerator Foundation (UXL), un consorzio industriale che include Intel, ARM, Qualcomm, Samsung e altri nomi con l’obiettivo di fornire un’alternativa a CUDA. PyTorch 2.0 è ottimizzato per utilizzare OneAPI per l’inferenza e l’addestramento con CPU e GPU Intel. D’altra parte, anche Intel OpenVINO è in rapida crescita, con oltre un milione di download finora quest’anno.

OpenVINO è un potente toolkit di deep learning sviluppato da Intel che ottimizza e accelera l’inferenza delle reti neurali su diverse piattaforme hardware. Questo strumento consente l’esecuzione efficiente di modelli di deep learning basati su reti neurali convoluzionali (CNN) e altri tipi di reti neurali su una vasta gamma di dispositivi Intel, come CPU, GPU, VPU, FPGA e altri acceleratori Intel. OpenVINO facilita lo sviluppo di applicazioni di computer vision, riconoscimento vocale automatico, elaborazione del linguaggio naturale, sistemi di raccomandazione e altro ancora, offrendo prestazioni elevate e opzioni di distribuzione flessibili, dall’edge al cloud.

Inoltre, OpenVINO fornisce un’ampia gamma di funzionalità, tra cui la possibilità di eseguire l’inferenza di modelli di deep learning, supportando modelli provenienti da diversi framework come TensorFlow, PyTorch, PaddlePaddle, ONNX e altri.

Nuovi processori Intel Xeon 6 a sostegno dei workload legati all’intelligenza artificiale

Oltre all’acceleratore Gaudi 3, Intel ha svelato i nuovi processori Xeon 6. Offrono una soluzione efficiente in termini di prestazioni per eseguire le attuali soluzioni GenAI, tra cui RAG, per produrre risultati argomentati e di qualità sfruttando le informazioni e la proprietà intellettuale della singola realtà aziendale.

I processori Intel Xeon 6 con i nuovi E-core (Sierra Forest) a elevata efficienza energetica assicureranno un’esperienza di primo livello: saranno lanciati sul mercato questo trimestre. Gli Intel Xeon 6 con P-core (Granite Rapids) offriranno prestazioni di IA migliorate e saranno presentati successivamente.

I primi sono accreditati di un miglioramento delle prestazioni per Watt di 2,4 volte e densità rack migliore di 2,7 volte rispetto ai processori Xeon di seconda generazione. Gli Xeon 6 con P-core incorporano il supporto software per il formato dati MXFP4, che riduce la latenza del token successivo fino a 6,5 volte rispetto allo Xeon di quarta generazione che utilizza FP16, con la possibilità di eseguire direttamente modelli Llama-2 con 70 miliardi di parametri.

/https://www.ilsoftware.it/app/uploads/2024/04/acceleratore-intel-gaudi-IA.jpg)

/https://www.ilsoftware.it/app/uploads/2025/03/lip-bu-tan-ceo-intel.jpg)

/https://www.ilsoftware.it/app/uploads/2025/03/ILSOFTWARE-7-1.jpg)

/https://www.ilsoftware.it/app/uploads/2025/03/chip-RISC-V-europeo.jpg)

/https://www.ilsoftware.it/app/uploads/2025/03/vulnerabilita-amd-zen-zentool.jpg)