Nel 2017 il direttore della ricerca di Facebook, Mark Chevillet, si era dato due anni di tempo per dimostrare che è possibile realizzare una tecnologia non invasiva in grado di leggere 100 parole al minuto esaminando l’attività cerebrale.

Alla scadenza del periodo di tempo che era stato fissato, Chevillet conferma che in futuro sarà possibile scrivere senza usare le mani, pensando solamente ciò che si desidera digitare.

L’obiettivo di Facebook è a questo punto quello di realizzare dei visori per la realtà aumentata che possano essere controllati senza dover parlare ad alta voce.

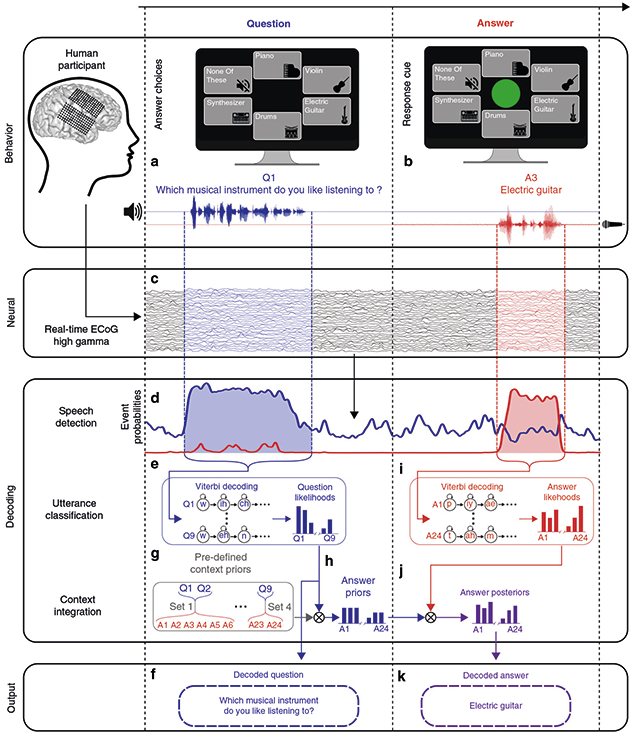

Un team composto da alcuni accademici dell’Università della California, finanziato da Facebook Reality Labs, ha costruito un’interfaccia cervello-computer che decodifica accuratamente parole e frasi di dialogo, sia ascoltate che pronunciate dalla persona che indossa il dispositivo esaminando in tempo reale i segnali cerebrali.

Edward Chang, uno dei responsabili della ricerca, neurochirurgo e responsabile del polo accademico californiano, spiega che il lavoro svolto apre scenari fino a ieri impensabili non solo nel settore della realtà virtuale e dell’intelligenza artificiale, campi di maggiore interesse per Facebook, ma anche nel segmento di mercato dei dispositivi biomedici. Strumenti come quello abbozzato possono essere utilizzati per ripristinare la comunicazione con quei pazienti che purtroppo hanno perso la capacità di parlare a causa di ictus, lesioni del midollo spinale o altre condizioni.

“Stiamo decodificando due tipi di informazioni provenienti da due diverse parti del cervello e le stiamo usando come contesto“, ha dichiarato Chang che spiega come questo approccio abbia un notevole impatto sulla precisione della decodifica dei segnali.

Il miglioramento della precisione si basa su un concetto semplice: aggiungere contesto. Utilizzando elettrodi impiantati nel cervello di tre pazienti volontari sottoposti a trattamento per l’epilessia, il team di Chang ha registrato l’attività cerebrale mentre i volontari hanno ascoltato una serie di domande pre-registrate quindi scandito ad alta voce le loro risposte.

I dati cerebrali sono stati utilizzati per addestrare algoritmi di apprendimento automatico (machine learning). Più tardi, quando ai partecipanti allo studio è stato chiesto di rispondere di nuovo alle domande, gli algoritmi hanno esaminato l’attività cerebrale per determinare se il soggetto stesse ascoltando o parlando per poi provare a decodificare il discorso.

Aggiungendo il contesto, le risposte sono risultate significativamente più facili da prevedere per un’interfaccia cervello-computer tanto che il sistema messo a punto è stato in grado di decodificare il parlato percepito e prodotto con una precisione, rispettivamente, fino al 76% e 61% utilizzando un insieme ristretto di domande e risposte specifiche. I risultati sono davvero incoraggianti anche se l’obiettivo è ovviamente quello, a questo punto, di ampliare il vocabolario utilizzato dal sistema.

Maggiori informazioni su IEEE Spectrum.

/https://www.ilsoftware.it/app/uploads/2023/05/img_19681.jpg)

/https://www.ilsoftware.it/app/uploads/2025/04/agcom-filtro-bloccare-spam-telefonico.jpg)

/https://www.ilsoftware.it/app/uploads/2025/04/wp_drafter_475604.jpg)

/https://www.ilsoftware.it/app/uploads/2025/04/flux_image_475352_1744787408.jpeg)

/https://www.ilsoftware.it/app/uploads/2025/01/2-11.jpg)